Arquivo para novembro 7th, 2017

Informar, conhecer e saber

Em tempos de crise cultural, a informação é abundante e nem sempre  verdadeira, o conhecimento é limitado e a sabedoria escassa.

verdadeira, o conhecimento é limitado e a sabedoria escassa.

Embora seja do senso comum que para conhecimento é necessário informar, pouco se sabe sobre o que é informação, e o pouco conhecimento tempo pouca chance em tornar-se sabedoria, então transbordam as “máximas” (frases feitas deslocadas de contexto), a autoajuda (nome impróprio para o autoconhecimento) e o fundamentalismo, miséria da filosofia.

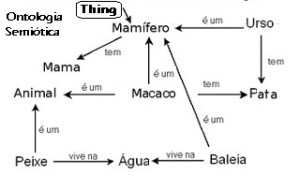

Há muitas possibilidades para a informação, mas se a considerarmos como presente na vida dos seres, então uma definição encontrada no Dicionário Contemporâneo da Língua Portuguesa que remete a origem da palavra no latim informatio (delinear ou conceber ideia) entende-se como dar forma ou moldar na mente, onde ela se in-forma, passando a informação a ser ontológica (exemplo acima).

Porém este formato seja na língua, linguagem ou em alguma forma de signos esta informação já existe, e esta relação está tem uma raiz semiótica dado por Beyno-Davies onde o conceito multifacetado de informação é explicado em termos de sinais e de sistemas de signos-sinais.

Para ele há quatro níveis interdependentes, ou camadas da semiótica: a programática, a semântica, a sintaxe e o empírico (ou experimental que prefiro pois não é empirismo).

Enquanto a Pragmática está preocupada com o propósito de comunicação, a Semântica se preocupa com o significado de uma mensagem transmitida em um ato comunicativo (que gera uma ontologia) e a Sintaxe está preocupada com o formalismo utilizado para representar uma mensagem.

A publicação da dissertação de Claude Shannon, em 1948, intitulada A Mathematical Theory of Communication é uma das fundações da teoria da informação onde a informação não somente tem um significado técnico mas também de medida, podendo ser chamada de sinal apenas.

Foi Michael Reddy que observou que “‘sinais’ da teoria matemática são “padrões que podem ser trocados”, neste sentido são códigos, onde a mensagem contida no sinal deve expressar a capacidade de “escolher dentre um conjunto de mensagens possíveis”, não tendo significado único, pois precisa ser “decodificada” entre as possibilidades que existem.

Deve ter certa quantidade de sinais para poder superar a incerteza do sinal transmitido, será conhecimento se a relação entre sinal e ruído (presente na codificação e transmissão do sinal) for relevante e o grau de entropia não tiver destruído o sinal transmitido.

A teoria da comunicação analisa a medida numérica da incerteza de um resultado, por isso tende a usar o conceito de entropia da informação, geralmente atribuído a Claude Shannon.

O conhecimento é aquilo que se obtém da informação quando ela transmitida pode ser retida de alguma forma na mente humana, a informação que permite isto é ontológica.