Arquivo para a ‘Circuitos’ Categoria

ARM será produzido pela Intel ?

Os mais antigos lembram-se da evolução dos PCs 186, 286, 386, até chegar ao  Pentium, que na verdade eram os nomes da evolução de seus processadores, mas depois continuou a existir a linha feita pela Intel chamada de x86, portanto para computadores e não para celulares.

Pentium, que na verdade eram os nomes da evolução de seus processadores, mas depois continuou a existir a linha feita pela Intel chamada de x86, portanto para computadores e não para celulares.

A linha mais forte nos celulares é a ARM, na verdade é apenas uma design de chip, chamado de Arquitetura de Computadores, e seu dono é a empresa britânica SoftBank que pagou US$ 32 bilhões para ser dona da tecnologia, quem fabrica especialmente para smartphones, são a Snapdragon, Samsung, Apple, MediaTek, Nvidia, AMD (neste caso para servidores).

Já haviam rumores que a Apple estaria solicitando a produção de chips pela Intel na tecnologia ARM, o site The Verge afirmou isto, e uma implicação imediata é que um problema sério para a Samsung e TSMC, que fabricam os chips feitos pela Apple, que produz 1 bilhão de iPhones.

As duas questões seguintes são a vitória dos processadores de baixo consumo, um dos quesitos do ARM sobre a linha x86, o que é especial para smartphones e uma maior velocidade de processamento.

Para especialistas da computação é uma vitória sem volta da arquitetura RISC (Reduced Instrution Set Code), computadores com poucas instruções de máquina, já que ARM significa Arquitetura Avançada RISC (Advanced Risc Arquitecture).

Produzido inicialmente pela inglesa Acorn Computers, a arquitetura era baseada no modelo Berkeley RISC I, o ARM2 tinha o equivalente a 30 mil transitores, o ARM6 evolui para 35 mil e o ARM7 que ficou mais famoso pois foi utilizado em alguns modelos de netbooks em 2009.

http://www.theverge.com/2016/8/16/12507568/intel-arm-mobile-chips-licensing-deal-idf-2016

Passar no caixa ficou rápido

Obras de ficção até recentemente, os relógios com sensores NFC (Near Field Communication) chegaram ao mercado brasileiro através do modelo Bellamy, com ele você aproxima o relógio do produto e o pagamento é feito em segundos.

Obras de ficção até recentemente, os relógios com sensores NFC (Near Field Communication) chegaram ao mercado brasileiro através do modelo Bellamy, com ele você aproxima o relógio do produto e o pagamento é feito em segundos.

A bateria dele dura anos, só que diferente dos cartões tradicionais no relógio não há nada que mostre que ele está sendo usado para compras tornando o pagamento discreto e seguro, e a parceria foi feita com a Visa e a Brasil Pré-Pagos.

Ele tem uma antena NFC, com um chip “contactless” da Visa que faz a comunicação com terminais de pagamento sem contato, assim que os são debitados os créditos são previamente feitos por uma função de pagamento bancário e a empresa garante que o crédito é seguro.

Como todo o mercado de tecnologia a mudança inicial é lenta, este tipo de dispositivo NFC já existente em algumas peças de roupas e artigos de luxo devem logo estar presentes no mais simples produto de supermercado, convivendo com os atuais códigos de barra, mas com o tempo o próprio código de barras pode sumir.

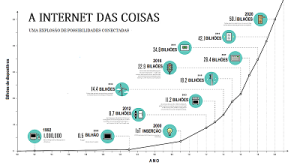

Internet das coisas vem ai

Se temos 7 bilhões de pessoas no mundo, das quais perto de 5 bilhões  estão conectadas, o número de dispositivos é de 50 bilhões e a conexão entre dispositivos poderá ser mudança ainda mais surpreendente que a que aconteceu com a internet: a internet das coisas (IoT).

estão conectadas, o número de dispositivos é de 50 bilhões e a conexão entre dispositivos poderá ser mudança ainda mais surpreendente que a que aconteceu com a internet: a internet das coisas (IoT).

Os protocolos até recentemente eram reduzidos, agora novos padrões começam a emergir além do conhecido BlueTooth, chega com força agora o ZBee ou ZigBee.

O BlueTooth também evoluiu para o BlueTooth Low-Energy (BLE) ou Smart Bluetooth, como protocolo antigo e conhecido para internet das coisas segue firme, uma vez que o consumo de energia é um item significativo para a aprovação das tecnologias IoT.

Mas ZigBee vem crescendo em número de aplicações e dispositivos, e começa a ganhar muito interesse em desenvolvedores, usado em automação de casas, edifícios e áreas industriais, usa um protocolo padronizado IEEE 802.15.4 que é uma tecnologia sem fio padrão industrial que opera para aplicações na faixa de 2,4 GHZ requerem pouca troca de dados e operam numa faixa de 100 m, portanto excelente para casas, edifícios ou industriais.

Uma evolução do ZBee é o padrão RF4CE que tem algumas vantagens para sistemas complexos com baixo consumo de energia, alta segurança, robustez e alta escalabilidade com adição de nós e pode ser inserida em redes de controle de sensores sem fio para aplicações M2M (Máquina para Máquina) na IoT.

A versão mais recente é o ZBee 3.0, que unifica todos padrões ZigBee em um único padrão.

Há outros padrões comentaremos nos próximos posts.

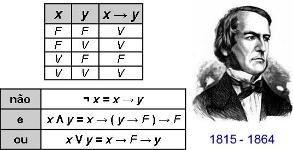

200 anos de George Boole

Nascido em 2 de novembro de 1815, a Álgebra que criou foi fundamental para o nascimento da lógica digital (0 e 1, ou V=Verdadeiro e F=Falso), e mais tarde no MIT, Vannevar Bush sugeriu para Claude Shannon que viria a se tornar um dos fundamentos da computação digital moderna.

nascimento da lógica digital (0 e 1, ou V=Verdadeiro e F=Falso), e mais tarde no MIT, Vannevar Bush sugeriu para Claude Shannon que viria a se tornar um dos fundamentos da computação digital moderna.

O desenvolvimento de Boole transformou-se em uma das importantes escolas da matemática, que influenciaria o filósofo Bertrand Russerl, que escreveu; “a matemática pura foi descoberta por Boole em seu trabalho ‘Leis do Pensamento’ “, que foi publicado em 1850.

Embora este seja um equívoco, pois o pensamento não se move por leis binárias, SIM e Não, pois existe o talvez, o poder e uma infinita variedade de possibilidades, Boole mais tarde fez um trabalho importante chamado de invariantes (ou cálculo das variações), que influenciou a Teoria da Relatividade de Albert Einstein.

Em 1838, publicou um opúsculo chamada A Análise Matemática da Lógica, que influenciou De Morgan que fez uma série de simplificações para tornar as leis da Algebra de Boole mais simples e fáceis se serem “adotadas” em processos mecânicos, eletromecânicos (relés que surgiram mais tarde) e todos dispositivos digitais que surgiram a partir destas “leis”.

Embora tenha morrido já com grande respeito, foi o trabalho Whitehead e Russel em Principia Mathematica (1910-1913) que convenceu os matemáticos que a lógica simbólica deveria receber sua séria atenção.

Velocidade e armazenamento: o limite do silício

Já há algum tempo o limite de velocidade e de armazenamento dos chips de silício está trazendo uma barreira para o avanço da computação eletrônica, que podemos dizer do futuro do armazenamento, um novo dispositivo chamado PCM (Phase Change Material) pode ser capaz de ultrapassar estas barreiras.

avanço da computação eletrônica, que podemos dizer do futuro do armazenamento, um novo dispositivo chamado PCM (Phase Change Material) pode ser capaz de ultrapassar estas barreiras.

Os novos processadores estão sendo produzidos por pesquisadores da Universidade de Cambridge, do Instituto A* STAR Data-Storage e da Universidade de Cingapura de Tecnologia e Design, usando um tipo de PCM com base num vidro de chalcogenidio, que pode ser fundido e cristalizado em menos da metade de um nanossegundo usado pulsos de tensão adequados.

A memória de estado sólido feita com base no silício, é utilizada para armazenar os resultados de feitos também em chips à base de silício. “No entanto, como a demanda por computadores mais rápidos continua a aumentar, estamos alcançando rapidamente os limites da capacidade do silício”, disse o professor Stephen Elliott, do Departamento de Química da Cambridge, que lidera a pesquisa.

Desenvolvido pela primeira vez na década de 1960, os PCMs foram originalmente usados em dispositivos de memória óptica, tais como DVDs regraváveis, mas agora estão começando a serem usados para aplicações de eletrônica de memória e já estão substituindo a memória flash baseada em silício em algumas marcas de smartphones.

Nestes dispositivos as operações lógicas e de memórias são co-localizados, em vez de separadas como nos computadores baseados no silício, podendo permitir velocidades de processamento entre 500 a 1000 vezes que um processador normal, usando menos energia, os resultados estão sendo publicados nos Processings da Academia Nacional de Ciências dos EUA.

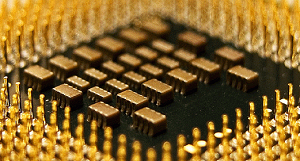

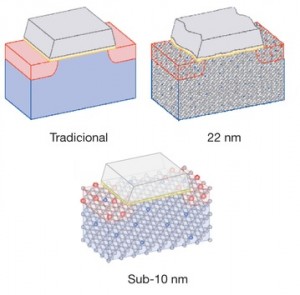

Limites reais da Lei de Moore

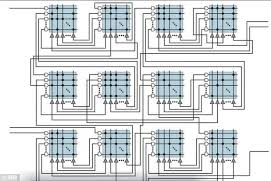

Quando milhares de transistores começaram a ser colocados dentro de pastilhas microscópicas dos chips, e a microcomputação nascia na década de 70, um engenheiro da Intel Gordon Moore formulou uma lei segundo a qual a cada dois anos o dobro de transistores eram colocados numa micro área das pastilhas de silício, e isto fez a velocidade e a capacidade dos microprocessadores chegarem aos bilhões de “transistores” por área (na casa dos 22 nm nanômetro), além de aumentar a velocidade hoje na casa dos GHz (GigaHertz)

nascia na década de 70, um engenheiro da Intel Gordon Moore formulou uma lei segundo a qual a cada dois anos o dobro de transistores eram colocados numa micro área das pastilhas de silício, e isto fez a velocidade e a capacidade dos microprocessadores chegarem aos bilhões de “transistores” por área (na casa dos 22 nm nanômetro), além de aumentar a velocidade hoje na casa dos GHz (GigaHertz)

Porém este é o limite do silício, por sua capacidade atômica e por isto temos que usar os “fans” (ventiladores) porque para o processamento, a velocidade e a área usada está “fritando” os chips que devem ser resfriados, mas o professor Igor Markov, publicou um artigo na revista Nature que explica melhor este fenômeno dos chips atuais.

Os engenheiros estão preocupados com o limite da Lei de Moore que está prestes a ser alcançado como a densidade de transistor se aproxima da escala atômica, mas Markov diz que há muitos fatores envolvidos além de tamanho e há maneiras de obter maior poder de computação além de escala, dizendo que há um problema de “eficiência energética”.

Markov argumenta ainda há inúmeros ganhos a serem feitos nesta área e novos materiais, tais como transistores de nanotubos de carbono, que poderiam ajudar a ter uma grande economia de energia que, por sua vez permitem maior poder computacional, em área que chegaria a 10nm.

Outra possibilidade já conhecida é a de explorar modelos naturais, tais como o cérebro humano, que é fundamentalmente diferente dos sistemas de computador existente tanto em termos de estrutura e funcionamento.

Mas Markov sabe que existem alguns limites físicos duros, estes limites são conhecidos como o comprimento de onda de Planck e o limite Berkenstein, que ainda não são o suficiente para que eles possam afetar computação, tanto quanto alguns suspeitam.

Repensando os computadores

A tecnologia de silício aparentemente chegou no seu limite, anunciamos em nosso último post um chip que tenta imitar as sinapses cerebrais, mas que depende de uma nova programação para efetivamente funcionar.

que tenta imitar as sinapses cerebrais, mas que depende de uma nova programação para efetivamente funcionar.

A HP já anunciou o esforço para repensar as tecnologias de computação, computação quântica e cognitiva parecem ser os novos enfoques, mas há pouca coisa realmente funcional e que esteja pronta para ir para o mercado.

Agora a IBM anunciou investimentos da ordem 3 milhões de dólares em projetos que querem repensar o modelo dos supercomputadores atuais, e o vice-presidente de Sistemas e Tecnologia da IBM, Tom Rosamilia, declarou a ComputerWorld, que a curto prazo são os processadores gráficos de alta performance que podem melhorar o desempenho dos computadores, mas a longo prazo “temos outros pontos que podem dar saltos passando de uma tecnologia para outra”, que significa materiais, arquiteturas e programação inteiramente novas, que significa misturar e combinar tecnologias novas propostas.

Os novos modelos significam que será necessário pensar programas e sistemas muito antes que as arquiteturas surjam, e a lei de Gordon Moore que dizia que o número de transistores dobraria a cada dois anos e enquanto isto foi verdade para o silício, não foi preciso mudar o modo de processar e de programar, agora os novos chips em sistemas totalmente novos podem exigir programação antecipada, para que quando surjam tenham algumas funcionalidades já operacionais.

Chip do tamanho de um selo

Um grupo de pesquisadores coordenados pela IBM criou um chip, que segundo o líder do grupo Dharmendra Modha será uma máquina para “uma nova era” e foi publicado na Science.

Dharmendra Modha será uma máquina para “uma nova era” e foi publicado na Science.

Mas as aplicações comerciais ainda podem levar ano, pois o software para este novo chip deverá ser escrito novo, porque o sistema de programação de hardware é todo novo.

Dharmenda declarou a BBC que o chip é resultado de “um trabalho cumulativo de mais de 200 anos-pessoa”, o que significa um esforço científico realmente grande.

O chip chamado de TrueNorth é próprio para as operações matemáticas são interconectadas, o que lhe permite trabalhar muito mais dados ao mesmo tempo.

“Nosso chip integra computação, comunicação e memória”, disse Modha.

A computação “neuromórfica” do TrueNorth acontece através de redes formadas por unidades chamadas “spikes” ou impulsos.

Cristal de memória do Superman é criado

Uma equipe de pesquisadores da Universidade de Southamptom, UK, criou um cristal capaz de armazenar informações digitais, em cinco dimensões, além das três convencionais do espaço, mais duas extras usando as nanoestruturas (estruturas no nível do átomo na ordem de 10 -9 m.

-9 m.

Estes dispositivos podem atingir a capacidade de 360TB de dados guardados, o equivalente a um milhão de vezes maior que um CD, por exemplo, de 360 GB, supondo que ele tenha um dispositivo de visualização e projeção, aquela memória da infância do Superhomem, seria praticamente possível agora.

Devido a semelhança com o filme, o dispositivo já é chamado de “cristal de memória do Superman”, pois lembra os cristais de memória do filme do Super-Homem.

Segundo o professor supervisor do projeto, Pete Kazansky é “emocionante pensar que foi criado o primeiro ‘documento’ capaz de sobreviver à raça humana”, pois esta “esta tecnologia pode armazenar as últimas evidências da civilização: tudo o que foi aprendido não será esquecido”, e em condições normais manterá as informações por 1 milhão de anos.

O paper ‘5D Data Storage by Ultrafast Laser Nanostructuring in Glass’ foi apresentado na Conference on Lasers and Electro-Optics (CLEO’13) em San Jose, Califórnia.

Como tornar as nuvens seguras

Este foi o problema tratado pela equipe de pesquisa do MIT, dirigida pelo professor Srini Devadas, os estudantes da graduação Ling Ren, Xiangyao Yu e Christopher Fletcher, assim como o pesquisador Marten van Dijk, trabalharam numa tipo de memória não coo um arranjo como é conhecido, mas em uma estrutura de dados conhecida como “árvore”, noticiado pelo MIT.

Este foi o problema tratado pela equipe de pesquisa do MIT, dirigida pelo professor Srini Devadas, os estudantes da graduação Ling Ren, Xiangyao Yu e Christopher Fletcher, assim como o pesquisador Marten van Dijk, trabalharam numa tipo de memória não coo um arranjo como é conhecido, mas em uma estrutura de dados conhecida como “árvore”, noticiado pelo MIT.

Cloud computing significa a terceirização de tarefas computacionais através da Internet, que por um lado possa dar aos usuários de computadores domésticos um poder de processamento sem precedentes e que as pequenas empresas possam usar de serviços de Web mais sofisticados, sem a construção de enormes bancos de dados em servidores.

Mas justamente esta terceirização pode levar a enormes problemas de segurança, como a nuvem é tratada como um condomínio, pode acontecer como citam no artigo de MIT apresentado num Simpósio Internacional de Arquitetura de Computadores, supondo um conjunto de servidores em nuvem para ter a execução de 1.000 aplicativos para clientes simultâneos, sem o conhecimento do exato serviço de hospedagem que é prestado, um desses aplicativos pode ter outra finalidade, a de espionar os outros 999.

No Simpósio Internacional de Arquitetura de Computadores recém acontecido junho, os pesquisadores do MIT descreveram um novo tipo de componente de hardware seguro, chamado Ascend, que misturam os padrões de memória de acesso a um servidor, o que torna impossível no caso de um atacante inferir nos dados que estão armazenados.

Mas talvez só as empresas poderosas e governos consigam usar isto, o que se discutem é quem pode controlar e não se o controle da informal é legal, vejam como todos os estados tratam Snowden, que fez a denuncia inicial de dados: algum país vai recebê-lo ?

Mas a solução no Brasil será o lançamento de um satélite brasileiro, dois cabos submarinos e a instalação de um Ponto de Troca de Tráfego (PTT) internacional, gostamos de coisas caras.