Arquivo para a ‘Plataformas’ Categoria

A narrativa eletrônica

A rápida evolução da Inteligência Artificial, depois de uma séria crise até o final do milênio, trás no cenário da divulgação científica e às vezes até mesmo na própria investigação científica, tanto um aspecto mistificador que a vê além das possibilidades reais ou aquém do que é capaz.

no cenário da divulgação científica e às vezes até mesmo na própria investigação científica, tanto um aspecto mistificador que a vê além das possibilidades reais ou aquém do que é capaz.

Por isso apontamos no post anterior a evolução real e sofisticação dos algoritmos de Machine Learning e o crescimento da tecnologia de Deep Learning, esta é a evolução rápida atual, a evolução dos assistentes eletrônicos (já estão no mercado vários deles como o Siri e a Alexa) é ainda limitada e comentamos num post sobre a máquina LaMBDA que teria capacidade “senciente”.

Senciente é diferente de consciência, porque é a capacidade dos seres de perceberem sensações e sentimentos através dos sentidos, isto significaria no caso das máquinas terem algo “subjetivo” (já falamos da limitação do termo e sua diferença da alma), embora elas sejam capazes de narrativas.

Esta narrativa or mais complexa que seja é uma narrativa eletrônica, um algorítmica, com a interação de homem e máquina através de um “deep learning” é possível que ela confunda e até mesmo surpreenda o ser humano com narrativas e elaborações de falas, porem dependerá sempre das narrativas humanas das quais são alimentadas e criam uma narrativa eletrônica.

Cito um exemplo do chatGPT que empolga o discurso mistificador e cria um alarme no discurso tecnófobo e cria especulações até mesmo sobre os limites transumanos da máquina.

Uma lista de filmes considerados extraordinários, exemplifica o limite da narrativa eletrônica, devido a sua alimentação humana, a lista dava os seguintes filmes: “Cidadão Kane” (1941), “O Poderoso Chefão” (1972), “De Volta para o Futuro” (1985), “Casablanca” (1942), “2001: Uma Odisseia no Espaço” (1968), “O Senhor dos Anéis: A Sociedade do Anel” (2001), “Um Sonho de Liberdade” (1994), “Psicose” (1960), “Star Wars: Episódio V – O Império Contra-Ataca” (1980) e “Pulp Fiction” (1994).

Nenhuma menção do japonês Akira Kurosawa, do alemão Werner Herzog ou do italiano Frederico Felini, só para citar alguns, sobre ficção não deixaria fora da lista Blade Runner – o caçador de androides, bem conectado as tecnologias do “open AI” ou o histórico Metrópolis (de 1927 do austríaco Fritz Lang).

A narrativa eletrônica tem a limitação daquilo que a alimenta que é a narrativa humana, mesmo sendo feita pelo mais sábio humano, terá limitações contextuais e históricas.

Twitter, Cibercultura e Paz Perpétua

A compra do Twitter por Elon Musk por U$ 44 bilhões, o bilionário da Space X e da Tesla, tornam as mídias de redes sociais cada vez mais atreladas ao campo político e balança o império das mídias tradicionais.

o bilionário da Space X e da Tesla, tornam as mídias de redes sociais cada vez mais atreladas ao campo político e balança o império das mídias tradicionais.

Uma das ideias básicas de Musk é tornar a rede menos controlada (a função de moderador) e com mais possibilidade de texto, no lançamento em 2006 era de 140, em 2017 foi ampliado para 280 e provavelmente acrescentará textos maiores, Musk é proprietário da ferramenta Revue.

A NetFlix perdeu 200 mil assinantes (pouco para 100 milhões de assinantes, mas uma tendência), CNN enfrenta fortes problemas com um discurso editorial (7 em cada 10 telespectadores) tenta mudar o enfoque, é a grande mídia sofrendo com o avanço das novas mídias, e tudo indica que a guerra no campo bélico e ideológico vai se deslocar para o campo cibernético, os drones praticamente aposentam a ideia de uso de tanques e aviões com autonomia de voo e de voo tornaram a guerra desigual em força e material bélico mais igual.

Mas a liberação da arbitragem no Twitter preocupa, embora a proposta de algoritmo de código aberto seja interessante, mas a grande questão são as ideias sobre a guerra de Musk.

Claro tudo isto é condenável pelo número de vítimas civis que causam, pelas tragédias humanas que ali se desenvolvem também entre militares que estão num campo de batalham onde muitos não gostariam de estar.

A Paz Perpétua de Kant trazia a proposta de um preceito da razão sobre o poder, porém um estranho ditado aparece no meio de seu texto (analisaremos o texto no próximo post), que é prudentes como as serpentes e suave como as pombas, no texto bíblico (Mt 10:16)é possível também se traduzir “simples como as pombas, porém a interpretação kantiana é divergente:

“…Sede prudentes como a serpente»; a moral acrescenta (como condição limitativa): «e sem falsidade como as pombas” (Kant, 2008, p.34), e o próprio Kant aponta que “as duas coisas não podem coexistir num preceito” uma contradição evidente, a Paz Perpétua é mais complexa, claro.

Este é o problema das novas mídias, é preciso usar o recurso muito usado na política de certa “falsidade”, ou dubiedade quer seja para despistar os opositores, quer seja para iludir o povo.

Não há como estabelecer a paz se não há respeito de culturas e valores conflitantes, claro dentro de limites humanitários razoáveis, o primeiro é a própria vida posta em cheque na guerra e o segundo é possibilitar a sobrevivência e autodeterminação dos povos para decidir seu destino.

KANT, I. A paz perpétua. Trad. Artur Mourão. Portugal: Universidade da Beira Interior Covilhã, 2008

Transformação digital além da Buzzword

Alertamos e problematizamos nos 10 anos deste blog a transformação que estava sendo encaminhada pelas mudanças digitais, aspectos sociais, educacionais, industriais e até mesmo comportamentais, boa parte dos céticos reagiam, ironizavam ou desprezavam uma mudança real que estava acontecendo.

que estava sendo encaminhada pelas mudanças digitais, aspectos sociais, educacionais, industriais e até mesmo comportamentais, boa parte dos céticos reagiam, ironizavam ou desprezavam uma mudança real que estava acontecendo.

A pandemia mostrou que as ferramentas mais do que necessárias podem construir pontes, estabelecer relações novas, dinamizar empresas e evitar desperdícios de tempo, dinheiro e principalmente nestes tempos por em perigo a saúde.

Agora todos vivem a realidade digital, empresas sobreviveram por serviços online, famílias, grupos sociais, serviços públicos e reuniões de diversos tipos dependem das ferramentas digitais, os espetáculos dependem de lives, de meetings ou postagens em ferramentas de mídias sociais.

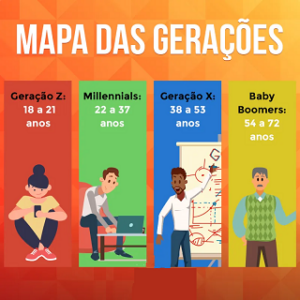

Uma buzzword surgiu muito forte a chamada “transformação digital”, porém o perigo do oportunismo é grande de empresas e sites que exploram e mistificam estes serviços e cobram caro por ele, assim alguns conceitos são necessários, primeiro o que acontece diferente na geração Z da anterior chamada de millennials, os que são nascidos no início do milênio, portanto antes do ano 2000, que agora tem de 22 a 37 anos.

Os millenials acompanharam a evolução a Web (as páginas, sites e blogs), nasceram numa realidade em que os computadores eram uma eletrodoméstico, assim só eram usados em casa e opcionalmente na escola, enquanto a geração Z através do celular levou o mundo digital a todo lugar, criam os grupos de chats e tem um comportamento diferente com a credibilidade dos sites, blogs e mídias de redes, criam suas próprias relações e ídolos, em geral diferente do tudo que é conhecido.

Embora mais fechados e com tendência a pouca relação social, são mais críticos que os millenials, mais ansiosos, são mais eficientes e são mais exigentes.

Assim as relações com o mercado são muito diferentes, voltam a preferir as compras em lojas físicas e selecionam bem o que compram, menos impulsivos e já tem a tecnologia com um excelente apoio, embora muito conectados já conhecem os limites da tecnologia.

Grandes revistas de economia como a Forbes e a Fortune fizeram análises da geração Z para entender a transformação de mercado necessária, a Forbes diz que ela representa 25% da população mundial atual, o meio digital é parte natural da vida deles, como a TV e o rádio das gerações passadas, enquanto a Fortune afirma que 32 da geração Z se esforça para um trabalho dos seus sonhos e descartam assumirem qualquer trabalho, embora temporariamente aceite para alçar o futuro.

Assim os CRMs ( Customer Relationship Management) antigos não funcionam e muitas críticas e análises feitas para a geração millenials estão ultrapassadas.

Segundo Kasey Panetta, pesquisadora da Gartner, 5 conceitos novos são emergentes: Composite architectures, arquiteturas ágeis e responsivas, Algorithmic trust, produtos, links, sites e transações confiáveis, Beyond silicon, os limites da lei de Moore da evolução dos computadores, agora tecnologias menores e mais ágeis são procuradas, Formative Artificial Intelligence (AI) adaptação ao cliente, customização dos serviços, tempos e localização, e o conceito Digital Me, uma espécie de passaporte para o mundo digital, ferramentas e sites que já conhecem o cliente e suas necessidades, formas de comportamento e preferencias.

Portanto todo o universo digital que parecia estável também vai desmoronar e muito do que se chama “transformação digital” é só uma mistificação digital, cuidado com oportunistas.

Panetta, Kasey. 5 Trends Drive the Gartner Hyper Cycle for Emerging Technologies, 2020. Disponível em: https://www.gartner.com/smarterwithgartner/5-trends-drive-the-gartner-hype-cycle-for-emerging-technologies-2020 , Acesso em: 15 de setembro de 2020.

2020: quais previsões para TI

São famosas e históricas as previsões na década de 70 pelos presidentes da Digital Equipments e IBM que os computadores pessoais não se tornariam realidade, mas no início de 80 já eram.

de 70 pelos presidentes da Digital Equipments e IBM que os computadores pessoais não se tornariam realidade, mas no início de 80 já eram.

A conceituada revista Wired dizia naquela época que eles aconteceriam, mas seriam primeiro adotados nas empresas e depois nas famílias, aconteceu o inverso.

As previsões da revista para a tradução simultânea eram para 2015, elas aconteceram em 2017 mas ainda existem reclamações de sua eficácia, a aposta nos carros com hidrogênio eram para o ano 2010, o que está se tornando realidade são os carros elétricos, lentamente por causa do mercado é verdade, mas também a tecnologia das baterias e autonomia dos caros ainda evolui.

Cinco tecnologias poderão entretanto mudar o mercado em 2020: 5G poderá entrar definitivamente no mercado mudando os negócios das operadoras de smartphones, multiclouds como evolução do armazenamento em nuvem será uma evolução das nuvens atuais, AI, em especial, Machine Learning entrará nas empresas e nos negócios dando impulsos a TI atual, e, finalmente muitas possibilidades de mobilidade podem mudar, com a evolução da IoT.

Até onde pode ir a AI

O projeto OpenAI que embora se diga “sem fins lucrativos” e seja realmente aberto, basta entrar no blog do projeto para verificar o andamento e as possibilidades, na verdade assuntou até mesmo os especialistas ao publicar um sistema que escreve notícias/textos, teoricamente de ficções, mas que podem ser classificados como fake, ou como estão sendo chamados: faketextos.

basta entrar no blog do projeto para verificar o andamento e as possibilidades, na verdade assuntou até mesmo os especialistas ao publicar um sistema que escreve notícias/textos, teoricamente de ficções, mas que podem ser classificados como fake, ou como estão sendo chamados: faketextos.

Também o código está aberto e disponível no site GitHub para desenvolvedores.

Os sistemas de processamento de linguagem natural podem fazer tarefas como responder questões, conversão de máquinas, compreensão de leitura e sumarização de textos, o que já são tipicamente abordadas com aprendizado supervisionado em conjuntos de dados específicos de tarefas, porém a pesquisa de textos no GPT2 é mais ampla em quantidade.

O GPT2, sucessor do GPT que era apenas um produtor de textos a partir de textos básicos, agora pode ler até 40 GB de textos existentes na Web, e o que tem produzido assusta um pouco, pela clareza, profundidade e o pior de tudo, pura ficção ou mais claramente: fakes.

Entre suas características sintáticas, é superior a outros do género, escrevendo passagens que fazem sentido com o texto anterior e mantém o estilo, sem se perder em frases longas.

O problema é que poderá gerar fakenews que agora podem ser mais longas, tornando-se faketextos, uma reportagem do The Guardian mostra a novidade e os problemas:

Web Summit em Lisboa

Um dos maiores eventos da Web realizou-se esta semana, estava num evento paralelo, só pude acompanhar por vídeos e noticias, sem dúvida a maior estrela foi o fundador da Web Tim-Berners Lee que já tem um grande projeto novo, embora tenha falado nas entrelinhas.

só pude acompanhar por vídeos e noticias, sem dúvida a maior estrela foi o fundador da Web Tim-Berners Lee que já tem um grande projeto novo, embora tenha falado nas entrelinhas.

Começou uma entrevista, que na verdade ele falou a vontade sem muitas perguntas dizendo o início da Web e como seu crescimento foi também surpreendente para ele, contou detalhes técnicos como “escrevi o código do primeiro servidor e o código do primeiro browser, chamava-se WorldWideWeb.app” e estava no site info.cern.ch .

Depois contou que sua preocupação é a mesma de todos, depois de 25 anos devemos lidar com: cyberbullying, desinformação, discurso de ódio, questões de privacidade e disse o que muitos estão a falar: “Que raio poderia correr mal?” dirigindo-se ao público: “nos primeiros 15 anos … grandes coisas aconteceram. Tivemos a Wikipedia, a Khan Academy, blogs, tivemos gatos” claro disse brincando, e acrescentou: “a Humanidade conectada deveria ser mais construtiva, mais pacífica, que a Humanidade desconectada”, mas sqn (só que não).

“Porque estamos quase no ponto em que metade do mundo estará online”, explicou o engenheiro britânico se referia-se ao momento ’50/50’, isto é metade da humanidade conectada que se esperava em 50 anos, mas deve chegar a este ponto em maio de 2019.

Depois de tentar argumentar responsabilidades de governos e empresas, creio que podem acontecer mas serão lentas, falou indiretamente de seu projeto SOLID (Social Linked Data), ao afirmar que ”como indivíduos temos de responsabilizar as empresas e os governos pelo que se passa na internet” e “a ideia é, a partir de agora, todos serem responsáveis por fazer da Web um lugar melhor”, disse incentivando start-ups também a entrar neste processo.

Pensar no desenvolvimento de interfaces onde os utilizadores conheçam pessoas de culturas diferentes, mas acima de tudo garantir a universalidade da Web, segundo Berners-Lee o principal aspecto deve ser (falando indiretamente de novo do SOLID) que a intervenção popular a nível global e que fez da Web “apenas uma plataforma, sem atitude, que deve ser independente, pode ser usada para qualquer tipo de informação, qualquer cultura, qualquer língua, qualquer hardware, software”, linked data poderá auxiliar isto.

Tim Berners-Lee apresentou o movimento #ForTheWeb no mesmo dia em que a sua World Wide Web Foundation divulgava o relatório “The Case for the Web”, o evento teve uma superaudiência, mais de 30 mil pessoas, há vários vídeos, mas o da Cerimonia de Abertura é um dos mais marcantes e tem Tim-Berners Lee também, veja: https://www.youtube.com/watch?v=lkzNZKCxMKc

Amanhã voltamos ao tema político, porém a Web se tornou política e por isto deve ser pensada por todos.

Wikipedia e Inteligência Artificial

Tendo já quase superada a questão do ponto de singularidade (ver nosso post), o ponto que a máquina ultrapassaria a inteligência humana, a questão se volta agora para a consciência e um ponto bastante abordado é a questão da consciência.

ultrapassaria a inteligência humana, a questão se volta agora para a consciência e um ponto bastante abordado é a questão da consciência.

Neste sentido a crítica principal é a perpetuação de preconceitos, o que evitaria o que chamo de hermenêutica, mas é uma visão incorreta da evolução da tecnologia digital, por exemplo, o uso de Ontologias Digitais e a capacidade de buscar estudos científicos fora do Wikipedia.

É o que anunciou recentemente um artigo do The Verge, e a omissão mais grave depois de pesquisar cientistas que são omitidos no Wikipedia, foi observar que 82% das biografias escritas são sobre homens.

Em um post no seu blog, conforme o site The Verge, John Bohannon, diretor da ciência da Primer, explica o desenvolvimento da ferramenta Quicksilver para ler 500 milhões de documentos originais, peneirar os números mais citados e depois escrever um artigo básico sobre o trabalho destes cientistas não citados no Wikipedia.

Dois exemplos de mulheres ilustres encontradas e para as quais foram escritas artigos em AI são o de Teresa Woodruff, uma cientista que projetou ovários para ratos com uso de impressoras 3D, foi citada pela revista Time em 2013, com uma das pessoas mais influentes no mundo científico, e outro caso é o de Jessica Wade, uma física do Imperial College London, que escreveu a nova entrada de Pineau.

Wade foi uma das cientistas que afirmou para a “Wikipedia é incrivelmente tendencioso, e a sub-representação das mulheres na ciência é particularmente ruim”, e elogiou o Quicksilver afirmando que com ele você pode encontrar rapidamente grande quantidade de informações muito rapidamente.

A Wikipedia terá que evoluir com ferramenta de Machine Learning, isto poderá acontecer nos próximos anos, o fato que existem ferramentas específicas para isto não invalida o Wikipedia, mostra que tem pontos fracos e devem ser corrigidos.

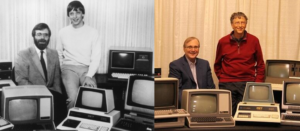

Morreu Paul Allen

Co-fundador com Bill Gates da Microsoft (foto), teve fortuna igualável e foi de fato o grande desenvolvedor da Microsoft, Bill Gates tinha trabalhado antes da Microsoft apenas numa versão da linguagem Basic, foi ele que sugeriu a compra do QDOS, sistema desenvolvido por Tim Paterson quando trabalha na Seattle Computer Products, de onde surgiu o MS DOS, cuja venda para a IBM é a origem do projeto milionário da Microsoft.

da Microsoft, Bill Gates tinha trabalhado antes da Microsoft apenas numa versão da linguagem Basic, foi ele que sugeriu a compra do QDOS, sistema desenvolvido por Tim Paterson quando trabalha na Seattle Computer Products, de onde surgiu o MS DOS, cuja venda para a IBM é a origem do projeto milionário da Microsoft.

Paul Allen conhecia o sistema MVT da Xerox Palo Alto, que foi inspiração para as primeiras versões do Windows, mais tarde também investiram no Explorer numa versão fortemente competitiva com o Netscape, que desencadeou a chamada guerra dos navegadores Web.

Paul Gardner Allen criou uma fundação com seu nome em 1988 para administrar projetos filantrópicos, entre 1990 e 2014 doou mais de 500 milhões de dólares a mais de 1500 organizações sem fins lucrativos, a maioria destinada a projetos de tecnologia, artes e cultura, mas também uma significativa fatia para desenvolvimento social (cerca de 100 milhões de dólares).

Morreu ao 65 vítima de câncer em sua cidade Seattle, onde era dono do time de basquete.

Isto é solido ou líquido

Parece uma brincadeira, não é a pergunta que aparece no projeto do site Solid, na verdade a pergunta lá é:  O que é Solid ? o novo projeto para internet de Tim Berners-Lee e o MIT.

O que é Solid ? o novo projeto para internet de Tim Berners-Lee e o MIT.

Depois da Web 2.0 que incluiu todo mundo, porém carecia de validar os dados, autoria e pensamentos, emergiu a partir de 2009 a Web 3.0, através do Linked Data, e isto está na composição do nome de Solid: Social Linked Data, embora a ideia do acrônimo central ela faz todo sentido, a ideia principal é descentralizar a Web, dar maior segurança dando aos usuários as possibilidades de controle total sobre o uso dos dados, como explica um artigo de Klint Finley na conceituada revista Wired.

A ideia principal é dar aos usuários individuais controle total sobre o uso de seus dados, porém com validação, autoria e tratamento de dados através do conceito de ligação entre eles (linked data).

A principal startup deste projeto é a Inrupt, segundo a revista Wired: “se tudo correr como planejado a Inrupt será para a Solid o que a Netscape foi para os iniciantes na rede (Web): uma maneira fácil de entrar, a revista foi convidada a conhecer o projeto no escritório de Berners-Lee, que revelou várias preocupações.

Apesar de todo bem que alcançamos, o ciclo de desigualdade e divisão, capturado por forças “poderosas que usam para seus próprios interesses”, disse Berners-Lee e acrescentou: “sempre acreditei que a rede é para todo mundo. Por isso, eu e outros lutamos aguerridamente para protege-la”, e agora um passo decisivo foi tomado.

A tela da Inrupt reunirá funções como o Whatsapp, google Drive, Spotify e Google Drive, parece tudo igual, a diferença é que o controle será pessoal, o indivíduo definirá suas prioridades e estratégias e não algoritmos das redes sociais.

Também é uma necessidade emergente porque basta olhar a tela de seu celular ou do computador, pessoalmente instalo poucas coisas, e vemos uma infinidade de aplicativos que nem usamos, é como um guarda roupa cheio de roupas velhas esperando uma ocasião que não vem.

O Projeto SOLID veio para ficar, ainda que seja um novato e muita coisa seja apenas promessa, é fácil de perceber sua viabilidade, necessidade e potencialidade pela chancela do MIT.

Projeto avançado Deep Mind

Projetos que tentavam simular sinapses cerebrais, a comunicação entre neurónios, foram anteriormente chamados de redes neurais ou neuronais, e tiveram um grande desenvolvimento e aplicações.

chamados de redes neurais ou neuronais, e tiveram um grande desenvolvimento e aplicações.

Aos poucos estes projetos foram se deslocando para estudos da mente e o código foi sendo dirigido para Machine Learning (Aprendizado por máquina) que agora usando redes neurais passou a ser chamado deep learning, um projeto avançado é o Google Brain.

Basicamente é um sistema para a criação e treinamento de redes neurais que detectam e decifram padrões e correlações em sistemas aplicados, embora análogo, apenas imitam a forma coo os humanos aprendem e raciocinam sobre determinados padrões.

O Deep Learning é um ramo da Machine Learning que opera um conjunto de algoritmos usado para modelar dados em um grafo profundo (redes complexas) com várias camadas de processamento, e que diferente do treinamento de redes neurais, operam com padrões tanto lineares como não lineares.

Uma plataforma que trabalha com este conceito é a Tensor Flow, originada de um projeto anterior chamado DistBelief, agora é um sistema de código aberto, lançado pela equipe da Apache 2.0, em novembro de 2015, o Google Brain usa esta plataforma.

Em maio de 2016, a Google anunciava para este sistema a TPU (Tensor Processing Unit), um acelerador de programas de inteligência artificial programável com habilidade de alta taxa de transferência para a aritmética de baixa precisão (8 bts), que executa modelos e não mais treina como faziam as redes neurais, inicia-se uma etapa da Deep Compute Engine.

O segundo passo deste processo no Google Compute Engine, a segunda geração de TPUs alcança até 180 teraflops (10^12 números reais) de desempenho, e montados em clusters de 64 TPUs, chegam a trabalhar até 11.5 petaflops.