Posts Tagged ‘Big Data’

Four IT buzzwords for 2020

Some words have already been used in an excessive  and mistaken way, we can mention disruptive technologies seen as any that have an impact on the market, when the problem is the scale of production and consumption, the data lakes, used to store raw data that do not they mean they are or can be handled easily (there are specific environments and tools for this), and the third term that is not new is also DevOps, which is the rapid implementation of codes with facilities to remove and correct possible bugs (errors in the code ).

and mistaken way, we can mention disruptive technologies seen as any that have an impact on the market, when the problem is the scale of production and consumption, the data lakes, used to store raw data that do not they mean they are or can be handled easily (there are specific environments and tools for this), and the third term that is not new is also DevOps, which is the rapid implementation of codes with facilities to remove and correct possible bugs (errors in the code ).

The four buzzwords that are expected to grow in 2020 and which represent a danger both in their use and in their implementation are BigData (yes it already existed in 2019 but its expansion is indicated as a large volume for 2020), AI ditto the previous one, Agile which means the rapid market change and corporate strategy, if misused will be a failure and ultimately and no less essential, and lastly, what has been called a “digital transformation”.

Let’s start with the last one, which includes the previous ones, including the 3 excluded from the analysis, digital transformation does not necessarily mean that “everything now changes with digital processes”, and of course it does not mean that nothing changes, depending on the area, the impact, the disruption (in the scale) it is clear that the impact can and should happen, but be careful with Agile.

Agile is the process of responding quickly to changes, but the answer does not mean being responsive in any situation, the vast majority deserve analysis such as transient market situations, seasonal processes, response to competition and in particular, changes in “fashion”.

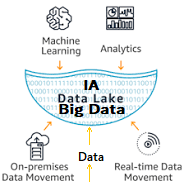

AI can be a response to many businesses, but the term “intelligence” itself is questioned, in fact it is a bit of each previous process, including bigData, Agile and Data lakes, that is, there must be tools like Analytics and Machine Learning that assist the process.

Gartner detected an increase from 25% to 37% from 2018 to 2019 in the use of AI for business, but the effectiveness is not guaranteed, just as only the use of IT does not mean the modernization of the company.

A curious problem of Big Data

Simon DeDeo a research in applied mathematics and complex systems of the Santa Fe Institute, had a problem , as posted in Wired magazine .

had a problem , as posted in Wired magazine .

He was collaborating on a new project to analyze data from the archives of the Old Bailey court in London criminal court central England and Wales 300 years . ”

But there were no clean data ( say structured ) as in a normal Excel spreadsheet format simple , including variables such as prosecution, trial and sentence in each case , but about 10 million words written over just under 200 000 trials .

How could analyze this data ? DeDeo question: ” It is not the size of the data set , it was difficult for patterns of large data size was quite manageable .” Was this enormous complexity and lack of formal structure that represented a problem for these ” big data ” that disturbed .

The paradigm of the research involved the formation of a hypothesis , decide precisely what it was intended to measure , then build a device to make this measurement accurately as possible , is not exactly like physics where you control variables and has a limited number of data.

Alessandro Vespignani , a physicist at Northeastern University , which specializes in harnessing the power of social networks to model disease outbreaks , the behavior of the stock market , the collective social dynamics , and electoral results , collected many terabytes of data networks social as Twitter , this approach can help treat texts written out of social networking .

Scientists like DeDeo Vespignani and make good use of this fragmented approach to the analysis of large data , but the mathematician at Yale University, Ronald Coifman says what is really needed is the large volume of data equivalent to a Newtonian revolution , comparing with the invention the calculation of the 17th century , which he believes is already underway .

Coifman says ” We have all the pieces of the puzzle – now how do we actually ride them ,” ie , we still have to move forward to address scattered data.

Big Data já é uma área de estudos

Embora seja o grande assunto do momento, o problema dos Grandes Dados (Big Data) pode carecer de realidade e conceitualização correta, comum em tudo que vira “moda”.

(Big Data) pode carecer de realidade e conceitualização correta, comum em tudo que vira “moda”.

Um trabalho publicado na Harvard Business Review, não só esclarece estes fatos, mas dá a eles uma realidade prática para o futuro de nossas vidas.

Os programas de dezenas de Universidades nasceram de uma forma que ficaram conhecidas como uma “constelação” que incluem a Universidade de Stanford, Northwestern, George Mason, Syracuse e a Universidade de Nova York, além de Harvard e Columbia.

Outra universidade que oferece um mestrado na área é a Universidade de Columbia, também a Universidade de São Francisco, Califórnia formará uma classe na área.

Rachel Schutt, uma cientista de pesquisa sênior da Johnson Research Labs, na Universidade de Columbia, dá um curso intitulado “Introdução à Ciência dos dados“, no último semestre da graduação da Universidade de Columbia.

Ela descreve o cientista dados como alguém que é : “um híbrido de cientista da computação, estatístico e engenheiro de software.”

Em 2012, ela criou um blog e desenvolveu algumas aulas, como uma que está num vídeo do TEDx, também é um dos primeiros cursos que podem ser encontrados em buscas.

É um dos primeiros trabalhos sobre Big Data sem muita fantasia, prático e claro.

O risco científico e o "Big Data"

As grandes pesquisas em computação estão se voltando para grandes volumes de dados, o chamado Big Data, conforme notícia do New York Times.

voltando para grandes volumes de dados, o chamado Big Data, conforme notícia do New York Times.

A Universidade de Columbia, para “debutar” seu novo Instituto de Ciências e Engenharia de Dados, realizou na última sexta-feira (05/04) um simpósio de um dia inteiro intitulado “Do Big Data às Big Ideias”.

O instituto é uma junção de centros interdisciplinares, para a segurança cibernética, análises financeiras, análises de saúde, novas mídias e cidades inteligentes.

Diversas análises sobre conjunto de tecnologias chamado Big Data, com novos dados e novas ferramentas de inteligência artificial, que poderão realmente transformar as indústrias, como novas capacidades de previsão.

O simpósio, “Do Big Data Para Big Ideas”, foi, principalmente, uma celebração da promessa da tecnologia nos campos de cuidados de saúde ao transporte, com apresentações de Columbia professores e cientistas da computação de empresas como Google, Facebook, Microsoft e Bloomberg.

Os perigos de privacidade e vigilância de Big Data também surgiram de passagem, mas durante uma seção de perguntas e respostas de um painel, o oficial de informações da Google, Ben Fried, expressou um receio. “Minha preocupação é que a tecnologia está muito à frente da sociedade”, disse Fried disse. “Há perigo”, ele sugeriu, “que apenas uma elite técnica entender Big Data e suas implicações, com o risco de uma tecnologia de fuga ou uma rejeição do público”.

Megaupload tenta renascer em 2013

Justamente na data de aniversário da invasão da casa de Kim DotCom, que foi em janeiro deste ano, DotCom o proprietário da Mega informou a Reuters que vai relançar o site que ficou famoso pelas hospedagem de filmes e músicas piratas, além de outras mídias.

Justamente na data de aniversário da invasão da casa de Kim DotCom, que foi em janeiro deste ano, DotCom o proprietário da Mega informou a Reuters que vai relançar o site que ficou famoso pelas hospedagem de filmes e músicas piratas, além de outras mídias.

Para o novo serviço vão usar um domínio interessante que será no Gabão, como a sigla de domínio lá é Ga, vai ficar interessante: Me.Ga, o site diz: “Nós prometemos, Nós entregamos” (WE PROMISSE, WE DELIVER).

Segundo DotCom o novo serviço “A Mega novos não serão ameaçados por promotores norte-americanos,” disse em entrevista à Reuters, acrescentando que o mega está confiante que vai evitar violar a lei dos EUA.

Grandes Dados e grandes impactos

É o que diz um relatório do Forum Econômico Mundial, o crescimento número de dados que podem influenciar decisões e controlar ou mesmo acelerar grandes impactos, é uma história recente e que já é estratégica para governos e empresas. Diversas organizações como o Instituto McKinsey, a Revista Nature e o Grupo Kimball, entre outros, destacam a importância estratégica do assunto.

influenciar decisões e controlar ou mesmo acelerar grandes impactos, é uma história recente e que já é estratégica para governos e empresas. Diversas organizações como o Instituto McKinsey, a Revista Nature e o Grupo Kimball, entre outros, destacam a importância estratégica do assunto.

Mas o que é um “Big Data”, ou Grandes Dados, o termo surgido no marketing, é uma abreviação para avançar tendências tecnológica que abrem a porta para uma nova abordagem e compreensão de como trabalhar dados que cresce 50% ao ano, relativos a tomadas de decisão estratégicas, segundo estimativas do IDC, uma empresas de pesquisa em tecnologia.

Não é mais o paradigmas de fluxo de dados, mas de dados inteiramente novos, por exemplo, existem inúmeros sensores digitais em todo o mundo em equipamentos industriais, automóveis, sensores elétricos e isto não significam dados acumulados, mas completamente modificados em períodos de tempo. Problemas de vibração, temperatura, umidade, mudanças químicas no ar que afetam estes sensores não fazem sentido em tempos anteriores, quando se trata de verificar os efeitos num veículos, por exemplo.

Outro exemplo, são dados governamentais, que estão migrando para a Web.O governo americano por exemplo, em 2009, divulgou ainda mais seus dados no site Data.gov, onde há todo tipo de dado governamental acessível ao público.

Os dados são não apenas se tornando mais disponíveis, mas também mais “tratáveis” por computadores. A maior parte do aumento de Grandes Dados, são dados de natureza diversas, como coisas escritas em palavras, imagens e vídeos na Web, mas serão os fluxos de dados de sensores que mais poderão mudar a natureza destes dados. Estão disponíveis nas “nuvens” e poristo são chamados de dados não estruturados, ou semi-estruturados e poristo não serão combustível para bancos de dados tradicionais.

Assim serão as ferramentas computacionais para o conhecimento, recolhendo e insights de vastos acervos era da Internet de dados, as que estão ganhando rapidamente terreno nos não estruturados, incluindo técnicas de inteligencia artificial, reconhecimento de padrões, processamento e aprendizagem por computador.