Arquivo para a ‘Computação – Hardware’ Categoria

A singularidade e os tecnoprofetas

Antes de Jean-Gabriel Ganascia falar sobre o Mito da Singularidade, a ideia que as máquinas iriam ultrapassar o homem em capacidade humana, já havia sido analisada por Hans Moracev em seu trabalho: Homens e Robots – o futuro das interfaces humanas e robótica, o cuidadoso e ético Ganascia não deixou de citá-lo.

ultrapassar o homem em capacidade humana, já havia sido analisada por Hans Moracev em seu trabalho: Homens e Robots – o futuro das interfaces humanas e robótica, o cuidadoso e ético Ganascia não deixou de citá-lo.

Existem grupos que estudam as questões éticas que isto envolve como o Centro para o estudo do risco existencial na Universidade Cambridge, mas também grupos empenhados neste projeto com a Universidade de Singularidade, com patrocinadores de peso como o Google, a Cisco, a Nokia, a Autodesk e muitos outros, mas também há estudos éticos como o Instituo para a Ética e as Tecnologias Emergentes que Ganascia participa, e o Instituto da Extropia.

Na conta dos tecnoprofetas, a palavra foi cunhada por Ganascia, um gênio preconceito Kurzweil é um dos mais extravagantes, injetava drogas no corpo se preparando para receber a “mente computacional”, porém com previsão para 2024 já falou e agora é para 2045 a 2049, algo que é incrível para alguém que se diz não ter crenças, pois este fato é muito longínquo, se ocorrer.

Ganascia pensa que isto é uma falsa profecia e Moracev analisa as difíceis possibilidades reais.

O instituto Gartner que trabalha com previsões razões prevê computação neuronal ainda engatinhando com previsões para daqui a 20 anos, interfaces como Alexa da Amazon e Sophia da Hanson, são máquinas de interação com humanos que aprendem coisas da linguagem cotidiana, mas estão longe das chamadas máquinas de uma inteligência artificial geral, isto porque o raciocínio humano não é um conjunto de cálculos proposicionais como pensam.

Alguém poderá argumentar mais isto é porque as pessoas são ilógicas, mas isto segundo qual lógica, o que sabemos é que homens não são máquinas e o que perguntamos se máquinas são homens, é a pergunta essencial que inspirou a série Blade Runner, o livro de Philip K. Dick “Andróides sonham com ovelhas elétricas” de 1968, que inspirou Blade Runner.

Penso que sonhos, imaginação e virtualidade são faces da alma humana, robôs não tem alma.

Um mundo criado em laboratório

A história de Claude Shannon, que trabalhava num laboratório do MIT de Vannevar Bush e Alain Turing se cruza em meio a II Guerra Mundial, quando trabalhando em projetos secretos, que eram dois lados da mesma moeda, sem saber um do projeto do outro, a ideia de passar a linguagem para um código humano, o System X que trabalhou Shannon, e, o de Turing que era decifrar o código da Máquina Enigma captura do exército alemão.

do MIT de Vannevar Bush e Alain Turing se cruza em meio a II Guerra Mundial, quando trabalhando em projetos secretos, que eram dois lados da mesma moeda, sem saber um do projeto do outro, a ideia de passar a linguagem para um código humano, o System X que trabalhou Shannon, e, o de Turing que era decifrar o código da Máquina Enigma captura do exército alemão.

Não podendo conversar sobre os seus projetos, falando em almoços e encontros do Teorema da Incompletude de Gödel, e a ideia de criar uma máquina que poderia codificar o pensamento humano, dizia em tom de piada, “podia ser um cérebro mundano como o do presidente da Bell Laboratories”, local de desenvolvimento dos projetos secretos das máquinas de codificação (System X) e decodificação da máquina alemã apelidada de Enigma.

Ela começou como um Laboratório em Washington da AT & T (Telefonia americana), e depois tornou-se um laboratório independente, local do desenvolvimento de inúmeros projetos (foto acima).

Os maiores obstáculos às iniciativas de inovação nascem dos bloqueios mentais causados por crenças, preconceitos e percepções não comprovadas sobre as possibilidades da tecnologia, estes além de fortemente alienantes, são inibidores da criatividade e podem condenar a processos de mal desenvolvimento de mentalidades.

Apesar da ironia de Shannon e Turing com o presidente da Bell Laboratories, lá se desenvolveram desde as primeiras válvulas, o primeiro transistor que valeu um Prêmio Nobel, os sistemas telefônicos em suas mais diversas versões chegando a linha discada e o uso da rede para transmissão pela internet, e o sistema de fibra ótima, cujo primeiro teste foi feito na Georgia.

Também linhas de aparelhos de rádio e televisão, o desenvolvimento do sistema UNIX precursor do Linux, as primeiras células solares, diversos prêmios Nobel e alunos famosos passaram por lá.

O desafio de pioneiros nunca é simples, os críticos estão sempre dispostos a desvalorizar o esforço humano de progresso, a Bell Laboratories e outros centros de estudos, como o CERN e Instituto de pesquisa em todo o mundo, o Brasil tem alguns deles como o INPE em São José dos Campos, são centro impulsionadores da criatividade humana e projetam o futuro do homem.

História do algoritmo

A ideia que podemos resolver problemas propondo um número finito de interações entre diversas tarefas (ou comandos como são chamados em linguagens de computação) para diversos problemas tem origem na Aritmética.

finito de interações entre diversas tarefas (ou comandos como são chamados em linguagens de computação) para diversos problemas tem origem na Aritmética.

Ainda que a máquina de Charles Babbage (1791-1871), e a Álgebra de Boole (1815-1864) tenham uma enorme contribuição para os modernos computadores, a maioria dos lógicos e historiadores do nascimento do mundo digital, concorda que o problema de fato foi levantado pelo segundo problema de David Hilbert (1962-1943), numa conferência de 1900, em Paris.

Entre 23 problemas para a matemática resolver, alguns resolvidos recentemente como o Conjectura de Goldbach (veja nosso post), e outros a resolver, o segundo problema se propunha a provar que a aritmética é consistente, livre de qualquer contradição interna.

Nos anos de 1930, dois lógicos matemáticos, Kurt Gödel (1906-1975) e Gerhard Gentzen (1909-1945) provaram dois resultados que chamavam de novo atenção ao problema proposto, ambos se referiam a Hilbert, então de fato, ali está a origem da questão, grosso modo, se um problema enumerável é resolvido por um conjunto finito de passos.

Na verdade, a solução de Gentzen era uma prova da consistência dos axiomas de Peano, publicada em 1936, mostrava que a prova de consistência pode ser obtida em um sistema mais fraco do que a teoria de Zermelo-Fraenkel, usava axiomas da aritmética primitiva recursiva, não sendo portanto uma prova geral.

Já a prova da inconsistência da aritmética, chamada de segundo teorema da incompletude de Gödel, é mais completa e mostra que não é possível alguma prova da consistência dos axiomas de Peano ser desenvolvida sem essa própria aritmética.

Esse teorema afirma: se os únicos procedimentos de prova aceitáveis são aqueles que podem ser formalizados dentro da aritmética, então o problema de Hilbert não pode ser resolvido, dito de outra forma mais direta, se ou o sistema é completo ou consistente.

Há polêmicas levantadas sobre estes resultados, como Kreisel (1976) que afirmou que as provas eram sintáticas para problemas semânticos, Detlefsen(1990) que diz que o teorema não proíbe a existência de uma prova de consistência, e Dawson(2006) que afirmou que a prova da consistência é errônea usando a prova dada por Gentzen e do próprio Gödel em trabalho de 1958.

Polêmicas a parte, a participação de Kurt Gödel no importante circulo de Viena na década de 20 antes da guerra explodir, e as posteriores discussões de seus teorema por Alain Turing (1912-1954) e Claude Shannon (1916-2001) atentam sua importância para a história dos algoritmos e dos modernos computadores digitais.

Uma forma de avançar na educação

As educações básicas precisas como disseram no primeiro post de empatia, capacidade de resolver conflitos e não será possível com a educação on-line atingir os níveis de escolarização para as faixas etárias mais baixas, mas a partir da primeira escolaridade.

de empatia, capacidade de resolver conflitos e não será possível com a educação on-line atingir os níveis de escolarização para as faixas etárias mais baixas, mas a partir da primeira escolaridade.

Chamo isto a idade até os 10 ou 12 anos, já é possível observar que o ensino on-line ajuda e pode ser de grande avanço, em especial para crianças que vivendo em países periféricos tenham capacidade de rendimento escolar acima do que seria próprio da sua idade, claro esta criança deve desfrutar de canais de empatia e sociabilidade normais da sua idade.

Porém no nível superior é que podemos ter saltos maiores de qualidade e propiciar uma alta escolarização em escala mundial, só para dar um exemplo, a Índia que ainda tem níveis de saúde e pobreza alarmante é um país gerador de cérebros e estudantes de alto nível.

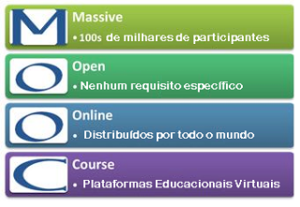

Os MOOCs (Massive Open Online Curses) é um tipo de curso aberto oferecido por meio de ambientes virtuais de aprendizagem, ferramentas da Web 2.0 ou redes sociais que visam oferecer para um grande número de alunos a oportunidade de cursarem sem a presença física em universidades e sem custos de moradia, transportes, etc.

Um fake News rodou este universo dizendo que os MOOCs nasceram em 2012 e faleceram em 2014, mas isto não é verdade, os números comprovam isto: os números atuais segundo o site Central-Class, o número de estudantes online é de 58 Milhões, distribuídos em mais de 700 universidades, em 6850 cursos, também os gráficos deste site mostram valores crescentes.

No Brasil grandes universidades já possuem cursos on-line, por exemplo: a FEA, da USP, tem um curso de Fundamentos de Administração (FEA/USP), disponível na plataforma Veduca, de educação online do Brasil, o curso gratuito é destinado a quem deseja aprender a administrar, outro curso é Responsabilidade Social e Sustentabilidade das Organizações (PUC/RS), curso da PUC do Rio Grande do Sul disponível na Miríada X, a Fisica de São Carlos tem o curso Física Básica (IFSC/USP), o curso tem carga horária de 59 horas divididas em 26 aulas e a UnB tem o curso Bioenergética (UNB), que permite ao interessado optar por apenas assistir às aulas ou obter o certificado.

As redes e relações (in)visíveis

Um dos assuntos em foco hoje são as redes sociais, elas não são de hoje, o problema é que hoje elas estão em evidencia, mas continuam a guardar certos aspectos de invisibilidade, confundidos com virtualidade, façamos uma análise histórica.

de hoje, o problema é que hoje elas estão em evidencia, mas continuam a guardar certos aspectos de invisibilidade, confundidos com virtualidade, façamos uma análise histórica.

As redes de comércio na antiguidade, por mar e por terra, os colégios invisíveis, definidos por Solla Price em seu trabalho “O desenvolvimento da ciência: análise histórica, filosófica, sociológica e econômica”, de 1976, chama as redes científicas de redes colaborativas, onde os pesquisadores se comunicam, trocam informações e experiências, significa que mesmo na ausência, através dos trabalhos impressos e das conferências, os autores colaboram.

Essencialmente, uma rede é uma teia de nós (elementos) e links (conexões) entre os nós, embora estes participantes sejam autônomos, as consequências das conexões em redes podem ultrapassar os seus próprios limites por conexão para “fora” através dos laços fracos.

Na análise de redes podem ser identificados apenas por razões didáticas, três tipos: as redes egocentradas (ego networking), as redes de análise global (Global Networking) e as redes de relações entre atores, chamadas TAR (Teoria Ator-Rede) com origem nos trabalhos de Michel Callon.

As redes de aeroportos, as redes de transportes de containers a nível mundial, as redes de telecomunicações e evidentemente a internet, a Web é uma camada sobre esta rede.

As redes globais são influenciadas fortemente pelas mídias, e elas criam certa dose de invisibilidade, uma vez que as redes colaborativas de publicações são também foram chamadas de colégios invisíveis por autores como Solla Price, mas aceleradas pela velocidade dos meios, os mídias eletrônicas tem maior velocidade de publicação e comunicação que a impressa, então blog, twitter e as mídias de redes sociais como Facebook ocupam um papel novo na atualidade, mas não são em si redes, mas mídias de redes.

Diversas medidas podem ser pensadas, a centralidade de proximidade (closeness) de um ator mede o quanto um nó está próximo de todos os outros, maior será a medida de proximidade, a centralidade de intermediação (betweenness) mede a importância de um nó na circulação da informação.

Então, para efeito de informação, o betweenness é a medida do controle que um ator detém no fluxo de informação e closeness é a facilidade que um ator tem do acesso à informação.

A invisibilidade, enfatizando presente nos colégios “invisíveis” na modernidade, é relativa ao processo de comunicação e informação que pode ir além dos autores-atores ao longo da rede, a virtualidade por sua vez refere-se a potencialidade de aumento da capacidade da rede.

Escutando não ouvem

O fato fisiológico de se escutar pode estar em contraste com a  apreensão do conteúdo no cérebro humano, isto é, pode-se ter um aparelho auditivo adequado ou até mesmo artefatos que ajudem, mas mesmo escutando não ouvem, isto é não apreendem o conteúdo.

apreensão do conteúdo no cérebro humano, isto é, pode-se ter um aparelho auditivo adequado ou até mesmo artefatos que ajudem, mas mesmo escutando não ouvem, isto é não apreendem o conteúdo.

A visão de McLuhan que a comunicação, como meio tende a ser definida como transparente, inócua, incapaz de determinar quais são os conteúdos comunicativos que estão veiculados.

A sua única incidência no artefato, seja ela qual for, no processo comunicação seria negativa, devido a ruídos ou obstáculos na veiculação da mensagem, esta já era a preocupação enquanto aparato de Claude Shannon, mas agora McLuhan chama que tanto a mensagem feita oralmente ou por escrito, seja ela transmitida por rádio, televisão, põe em jogo novas estruturas sendo elas artefatos destinados a ampliar os sentidos realçando contornos e outros nuances do que é comunicado, neste trabalho relaciona com o artista que deseja realçar algo.

Dito de forma mais direta, para McLuhan, o meio, o cana (termos mais apropriado para Shannon)l, os artefatos de tecnologia que a comunicação se estabelece, não é apenas constitui a de certa forma de comunicado, mas determinará em última instância o próprio conteúdo.

O que McLuhan chama a atenção é o facto de uma mensagem proferida tanto oralmente

quanto por escrito, ao ser transmitida pelo rádio ou pela televisão põe em jogo o conteúdo.

Sua tese central é que existe aí uma dupla operação: 1) estudar a evolução dos meios comunicativos usados pelos homens ao longo da sua História, e, 2) identificar as características especificas de cada um desses diferentes meios/artefatos de comunicação.

Estes são dois pontos centrais de sua investigação que estão na raiz de uma de suas obras fundamentais, a saber, Understanding Media, de 1964.

Assim desenvolve três galáxias, quando apenas uma é lembrada, a Galáxia de Gutenberg, que é típica da cultura escrita e depois a impressa com as possibilidades de reprodutibilidade, mas há a cultural oral ou acústica que é anterior, onde a questão da escuta é fundamental, nelas mestres (no sentido oral), oráculos e profetas ocupam um papel central, e, a atual que McLuhan chamava de eletrônica, mas pode-se como prolongamento falar de uma galáxia digital em rede, onde tem-se mídias de redes que não devem ser confundidas com as redes, pois estas existem nas galáxias anteriores.

Desta forma quem está preso a Galáxia de Gutenberg pode não escutar a Galáxia da cultura oral, e aqueles que estão presos a Galáxia dos meios eletrônicos, chamo-a de Shannon, não escutam a Galáxia da cultura oral e da Galáxia de Gutenberg, os artefatos multimodais poderão mudar isto?

Por uma filosofia do Design

Vilém Flusser foi um tcheco naturalizado brasileiro, falecido em 1991, que atuou por cerca de 20 ano s como professor de filosofia, jornalista, conferencista e escritor no Brasil e depois de volta no seu país de nascimento a Republica Tcheca.

s como professor de filosofia, jornalista, conferencista e escritor no Brasil e depois de volta no seu país de nascimento a Republica Tcheca.

Seus livros estão sendo republicados no Brasil, incluindo todos os seus escritos, e comecei relendo O mundo Codificado – por uma filosofia do Design.

Sua obra vai além das influências que recebeu de Roland Barthes, Marshall McLuhan, pois sua filosofia é própria com elementos de fenomenologia e existencialismo.

Na introdução do livro, feita por Rafael Cardoso, é destacada sua mudança de pensamento sobre as modernas mídias que apenas viu nascer: “ao contrário da maioria dos filósofos modernos, que costumam concentrar suas análises na linguagem verbal ou nos códigos matemáticos, Flusser dedicou boa parcela de seu gigantesco poder de reflexão às imagens e aos artefatos, elaborando as bases de uma legítima filosofia do design e da comunicação.” (FLUSSER, 2017, p. 10)

Lançou perguntas profundas sobre o mundo virtual: “Se uma árvore cai no espaço virtual, e não há ninguém on-line, será que ela gera uma mensagem de aviso?” retomando a famosa questão da árvore que cai na floresta, e também “Qual a diferença entre o material e o imaterial? Podemos trocar coisas por não coisas?” (idem) e conclui com uma pergunta ainda mais fundamental: “Que destino devemos reservar para os detritos gerados por nossa frenética atividade de transformação da natureza em cultura?” (FLUSSER, 2017, p. 15)

Aproxima-se do paradigma da informação, base essencial para o conhecimento e a educação, “o fim da história parecer ser o fim de nossa capacidade coletiva de lutar contra a entropia, contra a desagregação do sentido e da forma. Se a base daquilo que entendemos por cultura reside na ação de in + formar, então não é paradoxal que o excesso de informação nos conduza à desagregação do sentido ? “ (idem)

A importância do “conceito de virtualidade talvez seja a melhor e mais elegante prova do quanto Flusser tinha razão.” (idem), e não se pode mais fugir a esta questão, o uso em diversas formas de informação, comunicação e das artes exige a abertura desta “caixa preta”, nome de um ensaio publicado no ano de 1985.

Flusser ao contrário de apocalípticos, admite que “ao menos em tese”, o que deveria transformar-se em bem estar, ““humano torna-se escravo das forças de uma outra “natureza” que ajudou a gerar artificialmente”.

Aspectos da virtualidade e de um mundo codificado são desenvolvidos de maneira única pelo autor e contribuem para um debate mais sereno sobre as novas mídias.

FLUSSER, V. O mundo codificado: por uma filosofia do design. São Paulo: Ubu editora, 2017.

Princesa Léia: de Volta para o Futuro

Eu sei, são dois filmes distintos, porém a Universidade Brigham Young (BYU) parece retornar ao caminho da transmissão e projeção de imagens holográficas 3D no ar.

ao caminho da transmissão e projeção de imagens holográficas 3D no ar.

“Nossa equipe tem como missão tornar realidade os hologramas em 3D das ficções científicas” disse Daniel Smalley, professor de engenharia computacional e informática, um especialista em holografia que publicou recentemente (25/01) um artigo na Revista Nature.

A técnica que desenvolveu baseia-se no fenômeno da fotoforese, na qual partículas suspensas em meio a um líquido gasoso (há experiências com gotículas de água que o obriga a serem aspiradas no ar), podendo ser as próprias partículas que estão no ar atmosférico, que precisam ser movimentadas por gradientes térmicos e que pode ser feito por raios laser, explica Smalley “essas telas são capazes de produzir imagens em um ´ar fino’ que são visíveis de qualquer direção e não estão sujeitas a recortes”, ou seja, é visto de qualquer posição do espectador.

O nome técnico deste efeito é mais precisamente: “photophoretic-trap volumetric display” (uma tradução pode ser ´display de projeção volumétrica por armadilha fotoforética´), e é superior a técnicas antigas que não conseguiram capturar a luz por meio do ar para criar um objeto virtual com a mesma noção de profundidade do objeto real.

Mas o mais espetacular é a possibilidade de projeção RGB (Red-Green-Blue, as três cores primárias que compostas foram o espectro visível pelo ser humano), como o ponto de luz é capaz de mover-se rapidamente e assim o ponto de luz produz a cor, a projeção dos rádios laser verde, vermelho e azul produzem o efeito visual da cor.

A imagem colorida em três dimensões volumétrica (3D), terão a resolução de 10-micrómetro (10^-6 do metro ou 10^-4 do centímetro), isto significa produzir 10 mil voxels (Pixels volumétricos) por centímetro ou um milhão por metro cúbico.

Em pouco tempo a comunicação mudou, em 10 anos falamos pela Web em interação visual, graças ao VoIP (voz sobre Internet), agora a interação volumétricas em hologramas, ou também, assistir imagens de objetos e pessoas a nossa volta que estão a milhares de quilômetros de distancias, ou simplesmente, em filmagens de outros tempos, estamos de volta ao futuro.

Insegurança do hardware da Intel

O armazenamento de dados tinha 3 níveis: a memória externa (HDs), a  memória do computador (as memórias RAMs) e as bem internas antes chamadas Register (ficam no chip) e hoje de memória de núcleo, ficam no núcleo do computador e são as mais rápidas, mas também podem ser janelas para roubo de dados, hoje há um quarto nível que é a externa armazena em nuvens, centro de computação espalhados pelo mundo que vendem estes armazenamentos.

memória do computador (as memórias RAMs) e as bem internas antes chamadas Register (ficam no chip) e hoje de memória de núcleo, ficam no núcleo do computador e são as mais rápidas, mas também podem ser janelas para roubo de dados, hoje há um quarto nível que é a externa armazena em nuvens, centro de computação espalhados pelo mundo que vendem estes armazenamentos.

Um erro de produção dos chips da Intel, que chegam a quase 90% dos chips de computadores pelo mundo (o dos smartphones são muito diferentes), acaba de ser pega numa falha de projeto que dá vulnerabilidade para os dados.

A AMD, concorrente da Intel, aproveitou para manifestar que sua memória de Kernel (as memórias do núcleo do computador) não são afetadas por ataques de hackers, e não permite acesso a senhas e outros dados sigilosos da máquina, através dos quais os dados de um computador podem ser roubados.

Segundo afirmou Paul Kocher, presidente da empresa de segurança Rambus, para o New York Times, o problema pode ser maior se o acesso foi em nuvens, onde grande partes dos dados hoje já estão sendo armazenados, isto porque o compartilhamento de máquinas (e com isto compartilhamento das memórias de núcleo) podem ser feitos, mesmo se considerando o protocolo de segurança que evita acesso aos outros níveis de memória.

Problemas de segurança com as gigantes Amazon, Microsoft e Google, além da fabricante de chips Intel poderão sacudir o mercado, além da AMD outras concorrentes orientais devem estar de olho, de nossa parte alertamos para o chave problema.

Heidegger e a clareira

O termo é recorrente na filosofia, Platão falava de sair da caverna para a luz, na modernidade surgiu o iluminismo, e mais recentemente Heidegger falava da clareira, significando uma abertura no meio da floresta, portanto, a questão da falta de luz e noite escura não é nova.

luz, na modernidade surgiu o iluminismo, e mais recentemente Heidegger falava da clareira, significando uma abertura no meio da floresta, portanto, a questão da falta de luz e noite escura não é nova.

Mas estudando a etimologia da Clareira, retirando-a da filosofia de Heidegger, ela vem da palavra alemã Lichtung, onde além do significado de clareira na floresta (ele próprio viveu alguns anos na floresta negra da Alemanha), enquanto Licht é a palavra para luz, significará coisas ocultas, ou entes cuja verdade deve vir à tona, assim alguns tradutores usam desvelar.

A clareira é neste contexto o que está oculto dentro de um todo, onde deve emergir o ser, e isto parece mais apropriado a modernidade, visto que a fragmentação onde apenas emerge a parte, é na maioria das vezes oposta ao todo ao qual o ente pertence, assim a questão do Ser.

Assim a verdade, para os dias atuais, existe na abertura da parte para o todo, e é sensível o total fechamento da parte ao todo, não apenas como contexto, mas como parte integrante do Ser, e ao qual é preciso abertura para se chegar a verdade, não a afirmação referente ao objeto, mas a noção primordial da verdade que é a descoberta do ente em si mesmo.

O ente que se descobre, enunciou o próprio Heidegger: “deixa-se ver em seu ser e estar descoberto. O ser-verdadeiro (verdade) do enunciado deve ser entendido no sentido de ser-descobridor” (Heidegger, 1986, 219).

Primeiro vemos esta verdade ontológica como Ser, e não mais como lógica, segundo vemos esta relação entre conhecer o objeto e a própria relação com o Ser, o que na filosofia moderna poderia ser chamada de subjetividade, mas não é porque não são instâncias separadas.

O que se teoriza aqui, em conformidade com a teoria antropotécnica em extensão a sociotécnica, é que ao invés de tratar a diferença entre pensar o homem como o ente que “tem” objetos, no sentido de ser ele possuidor como as capacidades de falar, e construir objetos “externos”, a concepção ontológica que pensa o homem como “sendo” por meio dos objetos (a linguagem e a produção da sua própria vida e dos meios necessários a ela), permite entender todos os meios não apenas como veículo de transmissão de informações, mas como o modo no qual se manifesta o próprio existir humano, chamamos isto de onto-antropotécnica.

Na foto, artigo de Andrew Kessel para a revista SingularityHub, faz experimentos de recriação de objetos na vida real por computadores, em impressoras 3D, que é uma recriação dos objetos já ontologicamente criados.

HEIDEGGER, M. Sein und Zeit. 17 ed. Tübingen, Niemeyer, 1986.