Arquivo para agosto 19th, 2014

Limites reais da Lei de Moore

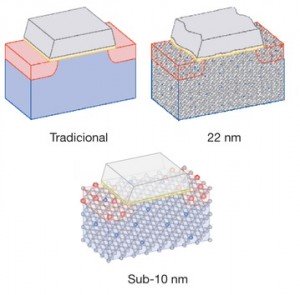

Quando milhares de transistores começaram a ser colocados dentro de pastilhas microscópicas dos chips, e a microcomputação nascia na década de 70, um engenheiro da Intel Gordon Moore formulou uma lei segundo a qual a cada dois anos o dobro de transistores eram colocados numa micro área das pastilhas de silício, e isto fez a velocidade e a capacidade dos microprocessadores chegarem aos bilhões de “transistores” por área (na casa dos 22 nm nanômetro), além de aumentar a velocidade hoje na casa dos GHz (GigaHertz)

nascia na década de 70, um engenheiro da Intel Gordon Moore formulou uma lei segundo a qual a cada dois anos o dobro de transistores eram colocados numa micro área das pastilhas de silício, e isto fez a velocidade e a capacidade dos microprocessadores chegarem aos bilhões de “transistores” por área (na casa dos 22 nm nanômetro), além de aumentar a velocidade hoje na casa dos GHz (GigaHertz)

Porém este é o limite do silício, por sua capacidade atômica e por isto temos que usar os “fans” (ventiladores) porque para o processamento, a velocidade e a área usada está “fritando” os chips que devem ser resfriados, mas o professor Igor Markov, publicou um artigo na revista Nature que explica melhor este fenômeno dos chips atuais.

Os engenheiros estão preocupados com o limite da Lei de Moore que está prestes a ser alcançado como a densidade de transistor se aproxima da escala atômica, mas Markov diz que há muitos fatores envolvidos além de tamanho e há maneiras de obter maior poder de computação além de escala, dizendo que há um problema de “eficiência energética”.

Markov argumenta ainda há inúmeros ganhos a serem feitos nesta área e novos materiais, tais como transistores de nanotubos de carbono, que poderiam ajudar a ter uma grande economia de energia que, por sua vez permitem maior poder computacional, em área que chegaria a 10nm.

Outra possibilidade já conhecida é a de explorar modelos naturais, tais como o cérebro humano, que é fundamentalmente diferente dos sistemas de computador existente tanto em termos de estrutura e funcionamento.

Mas Markov sabe que existem alguns limites físicos duros, estes limites são conhecidos como o comprimento de onda de Planck e o limite Berkenstein, que ainda não são o suficiente para que eles possam afetar computação, tanto quanto alguns suspeitam.