Arquivo para setembro 20th, 2016

Tecnologias significativas para Big Data

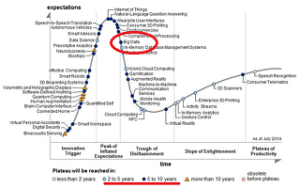

Big Data ainda é uma tecnologia emergente, no ciclo que vai do surgimento de uma tecnologia até a sua maturidade, se olharmos o hipociclo da curva de Gartner, veremos nela o Big Data na descendência desde o surgimento, até a desilusão, mas depois vem o ciclo da maturidade.

sua maturidade, se olharmos o hipociclo da curva de Gartner, veremos nela o Big Data na descendência desde o surgimento, até a desilusão, mas depois vem o ciclo da maturidade.

Para responder a questões propostas na TechRadar: Big Data, Q1 2017, um novo relatório foi produzido dizendo da 22 tecnologias de possíveis maturidades nos próximos ciclo de vida, entre as quais, 10 passos para “amadurecer” as tecnologias Big Data.

Na opinião desta pesquisa, os dez pontos que poderão, para incrementar o Big Data, são:

- A análise preditiva: soluções de software e / ou hardware que permitem que as empresas descobrem, avaliem, otimizem e implantem modelos preditivos através da análise de fontes de dados grandes para melhorar o desempenho dos negócios ou mitigação de risco.

- Serão necessários bancos de dados NoSQL: key-value, documentos e bases de dados gráfica.

- Pesquisa e descoberta de conhecimento: ferramentas e tecnologias para apoiar a extração de informações e novas perspectivas de auto-atendimento de grandes repositórios de dados não estruturados e estruturados que residem em múltiplas fontes, tais como sistemas de arquivos, bancos de dados, córregos, APIs e outras plataformas e aplicações.

- Fluxos de análises (analytics Stream): software que podem filtrar, agregar, enriquecer e analisar uma alta taxa de transferência de dados de múltiplas fontes de dados on-line díspares e em qualquer formato de dados (semi-estruturados).

- Análise persistente (In-memory) de “tecidos” de dados: permite o acesso de baixa latência e processamento de grandes quantidades de dados através da distribuição de dados através da memória de acesso aleatório dinâmico (DRAM), Flash, ou SSD de um sistema de computador distribuído.

- Arquivos de lojas Distribuídas: uma rede de computadores onde os dados são armazenados em mais de um nó, muitas vezes de forma replicada, tanto a redundância como desempenho.

- A virtualização de dados: uma tecnologia que fornece informações de várias fontes de dados, incluindo fontes grandes de dados, como a ferramenta Hadoop e armazenamentos de dados distribuídos em tempo real e ou tempo quase-real (pequenos delays).

Isto vai exigir as 3 ultimas etapas que a pesquisa sugere: 8. integração de dados: ferramentas para a orquestração de dados (Amazon Elastic MapReduce (EMR), Apache Hive, Apache Pig, Apache Spark, MapReduce, Couchbase, Hadoop, MongoDB), preparação de dados (modelagem, limpeza e compartilhamento) e a qualidade dos dados (enriquecimento e limpeza de dados em alta velocidade) serão necessários e feito isto, poderá tornar o Big Data produtivo “fornecendo valores de algo de crescimento através de uma Fase de Equilíbrio”.