Arquivo para a ‘Computação – Software’ Categoria

Novas linguagens e mudanças

Em outras épocas guardadas, as devidas proporções, as mudanças que ocorreram em etapas anteriores também causavam impressão forte nas pessoas, mas foram tecnologias disruptivas as que mais influenciaram, as lentes para óculos e telescópios, permitiram a leitura dos primeiros livros impressos, e graças aos telescópicos, a revolução de Copérnico aconteceu.

anteriores também causavam impressão forte nas pessoas, mas foram tecnologias disruptivas as que mais influenciaram, as lentes para óculos e telescópios, permitiram a leitura dos primeiros livros impressos, e graças aos telescópicos, a revolução de Copérnico aconteceu.

A mudança de paradigmas que acontece causa espantos, mas é preciso o que se realizará de fato, o que é possível numa realidade mais longínqua e o que poderá acontecer nos próximos anos, já indiquei em alguns post, A física do impossível, de Michio Kaku (2008).

O autor cita no início deste livro, a frase de Einstein: “Se inicialmente uma ideia não parecer absurda, então ela não terá qualquer futuro”, é preciso um pensamento forte e chocante como este para entender que se devemos apostar na inovação, e este é o momento histórico disto, deve entender que grande parte de coisas disruptivas serão inicialmente absurdas.

Falando de coisas mais distantes, no início dos microcomputadores, chegou-se a declarar que eles não teriam utilidade para muitas pessoas, o mouse era desajeitado e “pouco anatômico” quando surgiu, e ainda há muita desconfiança na “inteligência artificial”, não só entre leigos no assunto, entre estudiosos também, outros idealizam um “cérebro eletrônico”, mas nem a Sophia (o primeiro robô a ter cidadania) e o Alexa Amazon tem de fato “inteligência”.

O que é preciso frear, e isto no tempo de Copérnico valia para a visão teocêntrica, hoje há também uma sociopatia anti tecnologia que beira o fundamentalismo, se há injustiças e desigualdades elas devem ser combatidas no plano em que estão, no social e político.

Roland Barthes afirmou que toda recusa de uma linguagem “é uma morte”, com a adoção de tecnologia por milhões de pessoas esta morte se torna um conflito, primeiro entre gerações, e depois entre concepções de desenvolvimento e educação diferentes.

Aos estudiosos faço a recomendação de Heidegger, afirmava sobre o rádio e a televisão que apenas meia dúzia de pessoas entendiam o processo e claro com o poder financeiro podem controlar as editorias destas mídias, mas também pode-se responder no campo religioso.

A leitura do evangelista Marcos Mc 16,17-18 “Os sinais que acompanharão aqueles que crerem serão estes: expulsarão demônios em meu nome, falarão novas línguas; 18se pegarem em serpentes ou beberem algum veneno mortal, não lhes fará mal algum; quando impuserem as mãos sobre os doentes, eles ficarão curados”.

Isto precisa ser atualizado para os novos meios e linguagens modernas, assim como, o avanço da medicina que permitirá curar doenças e dar maior qualidade de vida a muitas pessoas.

KAKU, M. A física do Impossível: uma exploração científica do mundo dos fasers, campos de forças, teletransporte e viagens do tempo. 1ª. Edição. Lisboa: Editorial Bizâncio, 2008.

Tendências da Inteligência artificial

No final dos anos 80 as promessas e desafios da Inteligência artificial pareciam desmoronar a frase de Hans Moracev: “é fácil fazer os computado- res exibirem desempenho de nível adulto em testes de inteligência ou jogar damas, e é difícil ou impossível dar a eles as habilidades de um garoto de um ano quando se trata de percepção e mobilidade”, em seu livro de 1988 “Mind Children”.

de Hans Moracev: “é fácil fazer os computado- res exibirem desempenho de nível adulto em testes de inteligência ou jogar damas, e é difícil ou impossível dar a eles as habilidades de um garoto de um ano quando se trata de percepção e mobilidade”, em seu livro de 1988 “Mind Children”.

Também um dos maiores precursores da IA (Inteligência Artificial) Marvin Minsky e co-fundador do Laboratório de Inteligência Artificial, declarava no final dos anos 90: “A história da IA é engraçada, pois os primeiros feitos reais eram belas coisas, máquina que fazia demonstrações em lógica e saía-se bem no curso de cálculo. Mas, depois, a tentar fazer máquinas capazes de responder perguntas sobre históricas simples, máquina … 1º. ano do cicio básico. Hoje não há nenhuma máquina que consiga isto.” (KAKU, 2001, p. 131)

Minsky junto com outro precursor de IA: Seymor Papert, chegou a vislumbrar uma teoria d’A Sociedade da Mente, que buscava explicar como o que chamamos de inteligência poderia ser um produto da interação de partes não-inteligentes, mas o caminho da IA seria outro, ambos faleceram no ano de 2016 vendo a virada da IA, sem ver a “sociedade da mente” emergir.

Graças a uma demanda da nascente Web cujos dados careciam de “significado”, os trabalhos de IA vão se unir aos esforços dos projetistas da Web para desenvolver a chamada Web Semântica.

Já havia dispositivos os softbots, ou simplesmente bots, robôs de software que navegavam pelos dados brutos procurando “capturar alguma informação”, na prática eram scripts escritos para Web ou para a Internet, que poderiam agora ter uma função mais nobre do que roubar dados.

Renasceu assim a ideia de agentes inteligentes, vinda de fragmentos de código, ela passa a ter na Web uma função diferente, a de rastrear dados semiestruturados, armazená-los em bancos de dados diferenciados, que não são mais SQL (Structured Query Language), mas procurar questões dentro das perguntas e respostas que são feitas na Web, então estes bancos são chamados de No-SQL, e eles servirão de base também para o Big-Data.

O desafio emergente agora é construir taxonomias e ontologias com estas informações dispersas na Web, semi-estruturadas, que nem sempre estão respondendo a um questionário bem formulado ou a raciocínios lógicos dentro de uma construção formal clara.

Neste contexto emergiu o linked data, a ideia de ligar dados dos recursos na Web, investigando-os dentro das URI (Uniform Resource Identifier) que são os registros e localização de dados na Web.

O cenário perturbador no final dos anos 90 teve uma virada semântica nos anos 2000.

KAKU, M. A física do Impossível: uma exploração científica do mundo dos fasers, campos de forças, teletransporte e viagens do tempo. 1ª. Edição. Lisboa: Editorial Bizâncio, 2008.

A singularidade e os tecnoprofetas

Antes de Jean-Gabriel Ganascia falar sobre o Mito da Singularidade, a ideia que as máquinas iriam ultrapassar o homem em capacidade humana, já havia sido analisada por Hans Moracev em seu trabalho: Homens e Robots – o futuro das interfaces humanas e robótica, o cuidadoso e ético Ganascia não deixou de citá-lo.

ultrapassar o homem em capacidade humana, já havia sido analisada por Hans Moracev em seu trabalho: Homens e Robots – o futuro das interfaces humanas e robótica, o cuidadoso e ético Ganascia não deixou de citá-lo.

Existem grupos que estudam as questões éticas que isto envolve como o Centro para o estudo do risco existencial na Universidade Cambridge, mas também grupos empenhados neste projeto com a Universidade de Singularidade, com patrocinadores de peso como o Google, a Cisco, a Nokia, a Autodesk e muitos outros, mas também há estudos éticos como o Instituo para a Ética e as Tecnologias Emergentes que Ganascia participa, e o Instituto da Extropia.

Na conta dos tecnoprofetas, a palavra foi cunhada por Ganascia, um gênio preconceito Kurzweil é um dos mais extravagantes, injetava drogas no corpo se preparando para receber a “mente computacional”, porém com previsão para 2024 já falou e agora é para 2045 a 2049, algo que é incrível para alguém que se diz não ter crenças, pois este fato é muito longínquo, se ocorrer.

Ganascia pensa que isto é uma falsa profecia e Moracev analisa as difíceis possibilidades reais.

O instituto Gartner que trabalha com previsões razões prevê computação neuronal ainda engatinhando com previsões para daqui a 20 anos, interfaces como Alexa da Amazon e Sophia da Hanson, são máquinas de interação com humanos que aprendem coisas da linguagem cotidiana, mas estão longe das chamadas máquinas de uma inteligência artificial geral, isto porque o raciocínio humano não é um conjunto de cálculos proposicionais como pensam.

Alguém poderá argumentar mais isto é porque as pessoas são ilógicas, mas isto segundo qual lógica, o que sabemos é que homens não são máquinas e o que perguntamos se máquinas são homens, é a pergunta essencial que inspirou a série Blade Runner, o livro de Philip K. Dick “Andróides sonham com ovelhas elétricas” de 1968, que inspirou Blade Runner.

Penso que sonhos, imaginação e virtualidade são faces da alma humana, robôs não tem alma.

História do algoritmo

A ideia que podemos resolver problemas propondo um número finito de interações entre diversas tarefas (ou comandos como são chamados em linguagens de computação) para diversos problemas tem origem na Aritmética.

finito de interações entre diversas tarefas (ou comandos como são chamados em linguagens de computação) para diversos problemas tem origem na Aritmética.

Ainda que a máquina de Charles Babbage (1791-1871), e a Álgebra de Boole (1815-1864) tenham uma enorme contribuição para os modernos computadores, a maioria dos lógicos e historiadores do nascimento do mundo digital, concorda que o problema de fato foi levantado pelo segundo problema de David Hilbert (1962-1943), numa conferência de 1900, em Paris.

Entre 23 problemas para a matemática resolver, alguns resolvidos recentemente como o Conjectura de Goldbach (veja nosso post), e outros a resolver, o segundo problema se propunha a provar que a aritmética é consistente, livre de qualquer contradição interna.

Nos anos de 1930, dois lógicos matemáticos, Kurt Gödel (1906-1975) e Gerhard Gentzen (1909-1945) provaram dois resultados que chamavam de novo atenção ao problema proposto, ambos se referiam a Hilbert, então de fato, ali está a origem da questão, grosso modo, se um problema enumerável é resolvido por um conjunto finito de passos.

Na verdade, a solução de Gentzen era uma prova da consistência dos axiomas de Peano, publicada em 1936, mostrava que a prova de consistência pode ser obtida em um sistema mais fraco do que a teoria de Zermelo-Fraenkel, usava axiomas da aritmética primitiva recursiva, não sendo portanto uma prova geral.

Já a prova da inconsistência da aritmética, chamada de segundo teorema da incompletude de Gödel, é mais completa e mostra que não é possível alguma prova da consistência dos axiomas de Peano ser desenvolvida sem essa própria aritmética.

Esse teorema afirma: se os únicos procedimentos de prova aceitáveis são aqueles que podem ser formalizados dentro da aritmética, então o problema de Hilbert não pode ser resolvido, dito de outra forma mais direta, se ou o sistema é completo ou consistente.

Há polêmicas levantadas sobre estes resultados, como Kreisel (1976) que afirmou que as provas eram sintáticas para problemas semânticos, Detlefsen(1990) que diz que o teorema não proíbe a existência de uma prova de consistência, e Dawson(2006) que afirmou que a prova da consistência é errônea usando a prova dada por Gentzen e do próprio Gödel em trabalho de 1958.

Polêmicas a parte, a participação de Kurt Gödel no importante circulo de Viena na década de 20 antes da guerra explodir, e as posteriores discussões de seus teorema por Alain Turing (1912-1954) e Claude Shannon (1916-2001) atentam sua importância para a história dos algoritmos e dos modernos computadores digitais.

As tecnologias que vão dominar 2018

Uma sem dúvida que está na ordem do dia, mas deve crescer até 2021, são as Realidades Virtual e Aumentada, com a diferença que a primeira é a criação de um ambiente totalmente virtual enquanto a segunda é uma inserção de virtualidades no ambiente real, o Pokemon Go, segunda versão dos monstrinhos cresceu em 2017.

As estimativas de grupos de pesquisa como o Gartner e TechCrunch, este mercado (RV e RA)  vai movimentar mais de 100 bilhões de dólares até 2021, como o ano que vem é de Copa, o Japão por exemplos promete transmissões inéditas para 2022 no Quatar.

vai movimentar mais de 100 bilhões de dólares até 2021, como o ano que vem é de Copa, o Japão por exemplos promete transmissões inéditas para 2022 no Quatar.

A internet das coisas vai aumentando suas possibilidades, quanto pensavamos que a tecnologia de redes 5G estivesse distante nos EUA já está em funcionamento em muitos lugares e poderá ser uma realidade no próximo ano, com isto a internet das coisas que depende desta transmissão eficiência poderá alcançar novos rumos como os sistemas de água, energia de baixo custo e sofisticados sistemas de controle de transito, entrando finalmente o IoT (Internet das Coisas) na vida das pessoas.

Outra preocupação, mas não sabemos se os sistemas se tornarão mais eficientes, são os sistemas de segurança este ano o WannaCry afetou sistemas de telefonia e o FedEX, entre outras, chegando a afetar mais de 150 países, há promessas para 2018.

A produção de dados chegou a 2.5 exabytes por dia (1 exabyte = 10^18 bytes), e a tecnologia do BigData veio para ficar, mas uma aliada importante na manipulação e tratamento destes dados deverá ser a Inteligência Artificial (foto visão de um cérebro poligonal), os agentes inteligentes que dominarão a Web 4.0 deverão aparecer este ano, mas a previsão para tornar-se realidade na Web é para 2020.

Impressora 3D e nanotecnologia já são realidade, mas devem avançar, assim como a realidade precoce da internet 5G, postamos no dia de ontem os aparelhos “novidades”, o smartphone conceitual e a câmera de 360 graus, na tecnologia as vezes de surpresa estas coisas bombam.

A tecnologia faz parte da história da humanidade, postaremos amanhã sobre o ano de 2017.

.

Arte, autonomia e ver

O que permanece velado na arte recente e que está presente no discurso de Hegel e mais ainda na aparente ruptura com a saída do “plano” para as formas tridimensionais do “polido” é ainda uma arte idealista daquilo que Hegel chamou de “autonomia” e que devido ao este idealismo, Rancière chamou de “autonomização”.

aparente ruptura com a saída do “plano” para as formas tridimensionais do “polido” é ainda uma arte idealista daquilo que Hegel chamou de “autonomia” e que devido ao este idealismo, Rancière chamou de “autonomização”.

Esclarece Rancière que é a autonomização: “um desses elementos, a ´ruptura dos fios de representação´que os atavam à reprodução de um modo de vida repetitivo. É a substituição desses objetos pela luz de sua aparição. A partir daí, o que acontece é uma epifania do visível, uma autonomia da presença pictural.” (RANCIÈRE, 2003, p. 87)

É em última instância esta autonomização a famosa “arte pela arte” ou no sentido oposto a “utilitarismo da arte”, mas ambas não podem negar nem o aspecto específico da arte e sua ligação com as palavras nem a sua utilidade “tão útil quanto o útil” diria o escritor Vitor Hugo, mas trata-se de aceitar a emancipação do espectador pela “interação”.

Ver em arte escreve Rancière: “quer se trate de uma Descida da cruz ou um Quadrado branco sobre fundo branco, significa ver duas coisas de uma só vez” (Rancière, 2003, p. 87), que é uma relação entre: “a exposição das formas e superfície de inscrição das palavras.” (idem), onde as presenças são “dois regimes do trançado de palavras e formas.” (ibidem)

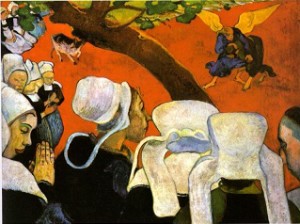

Para entender o problema da visão Rancière lança mão do quadro de Gauguin Camponesas no campo, há um “primeiro quadro: camponesas num quadro olham os lutadores ao longe” (Ranciére, 2003, p. 95), a presença e a maneira como estão vestidas mostram que é outra coisa então surge um segundo quadro: “devem estar numa igreja” (idem), para dar sentido o lugar deveria ser menos grotesco e a pintura realista e regionalista não é encontrada, então há um terceiro quadro: “O espetáculo que ele representa não tem um lugar real. É puramente ideal. As camponesas não veem uma cena realista de pregação e luta. Elas veem – e nós vemos – a Voz do pregador, isto é, a palavra do Verbo que passa por essa voz. Essa voz fala de combate lendário de Jacó com o Anjo, da materialidade terrestre com a idealidade celestial.” (Ibidem)

Assim desse modo afirma Rancière, a descrição é uma substituição, a palavra pela imagem, e as substitui “por outra ´palavra viva´, a palavra das escrituras.” (RANCIÈRE, 2003,P. 96)

Faz ainda uma ligação com os quadros de Kandinsky, escrevendo: “No espaço da visibilidade que seu texto constrói o quadro de Gauguin já é um quadro como os que Kandinsky pintará e que justificará: uma superfície em que linhas e cores se tornam sinais mais expressivos obedecendo a coerção única da ´necessidade interior´ ” (Rancière, 2003, p. 97), e já explicamos anteriormente não se trata nem de subjetivismo puro pois faz uma ligação com tanto com o pensamento interior quanto ao pensamento sobre a descrição no quadro.

O importante é a simbiose entre a imagem, as palavras e a visão decorrente de um “desvelar” da imagem que pode ser traduzida em palavras.

O Significado das Culturas Computacionais

Resumo da Palestra do prof. Dr. Teixeira Coelho do IEA – USP no evento  EBICC.

EBICC.

As máquinas estão se humanizando ou são osseres humanos que estão perdendo a humanidade e se transformando em produtos imediatistas, tão valiosos quanto excessivos e totalmente subtuíveis, dos quais o mundo está lotado?

A palestra apresentou como resultados do grupo de estudos Humanidades Computacionais do Instituto de Estudos

Avançados da USP uma lista de conceitos, a maioria com visão crítica da tecnologia, termos como: digitalização, mobilidade, automação, realidade aumentada, efeito-proxy, duplicabilidade, anonimato, perfectibilidade, racionalidade, coordenação, unificabilidade e completibilidade, entre outros, como resultado de uma e-culture (cultura eletrônica digital).

Discutiu a realidade contemporânea das culturas computacionais e digitais e sua relação com a produção cultural, mediada ou autoproduzida, em um contexto em que o trabalho de robôs substitui o trabalho manual dos humanos e caminha para substituir, por meio da inteligência artificial, o trabalho intelectual.

Em seguida Gregory Chaitin proferiu a sua palestra, já comentada no post anterior.

Consciência e Informação

O evento EBICC recebe hoje (31 de outubro) a palestra de Gregory Chaitin,  matemática e cientista de informática que apresentou o Theorema da Incompletude de Gödel e ele é considerado um dos fundadores da atual complexidade de Kolmogorov (ou Kolmogorov-Chaitin) juntamente com Andrei Kolmogorov e Ray Solomonoff.

matemática e cientista de informática que apresentou o Theorema da Incompletude de Gödel e ele é considerado um dos fundadores da atual complexidade de Kolmogorov (ou Kolmogorov-Chaitin) juntamente com Andrei Kolmogorov e Ray Solomonoff.

Hoje, a teoria da informação algorítmica é um assunto comum em qualquer currículo de ciência da computação.

Resumo:

Ele faz uma revisão das aplicações do conceito de complexidade ou informação algorítmica em física, matemática, biologia e até mesmo do cérebro humano, e propõe a construção do universo de informações e de computação, em vez de matéria e energia, o que seria uma visão de mundo muito mais amigável para discussões sobre a mente e a consciência do que o permitido pelo materialismo tradicional.

Os fundamentos de seu pensamento pode ser encontrado no livro: Meta Mat – Em Busca do Omega. SP: Editora Perspectiva, 2009.

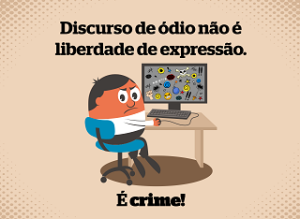

AI pode detectar discurso de ódio

É crescente nas mídias sociais o discurso de ódio, identifica-lo com uma única fonte  pode ser perigoso e tendencioso, em função disto pesquisadores da Finlândia treinaram um algoritmo de aprendizagem para identificar o discurso do ódio comparando-o computacionalmente com o que diferencia o texto que inclui o discurso em um sistema de categorização como “de ódio”.

pode ser perigoso e tendencioso, em função disto pesquisadores da Finlândia treinaram um algoritmo de aprendizagem para identificar o discurso do ódio comparando-o computacionalmente com o que diferencia o texto que inclui o discurso em um sistema de categorização como “de ódio”.

Os pesquisadores empregaram o algoritmo diariamente para visualizar todo o conteúdo aberto que os candidatos em eleições municipais geraram tanto no Facebook como no Twitter.

O algoritmo foi ensinado usando milhares de mensagem, que foram analisadas de forma cruzada para confirmar a validade científica, segundo Salla-Maaria Laaksonen, da Universidade de Helsinque: “Ao categorizar as mensagens, o pesquisador deve tomar uma posição sobre a linguagem e o contexto e, portanto, é importante que várias pessoas participem na interpretação do material didático”, por exemplo, fazer um discurso odioso para defender-se de uma ação odiosa.

O algoritmo foi ensinado usando milhares de mensagens, que foram analisadas de forma cruzada para confirmar a validade científica, explica Salla-Maaria:“When categorizing messages, the researcher has to take a stance on the language and context, and it is therefore important that several people participate in interpreting the teaching material,” says the University of Helsinki’s Salla-Maaria Laaksonen. “ao categorizar as mensagens, o pesquisador deve tomar uma posição sobre a linguagem e o contexto e, portanto, é importante que várias pessoas participem na interpretação do material didático”, senão o ódio pode ser identificado apenas unilateralmente. She says social media services and platforms could identify hate speech if they wanted to, and in that way influence the activities of Internet users.

Ela diz que os serviços e plataformas de mídia social podem identificar o discurso de ódio se quiserem, e dessa forma influenciam as atividades dos usuários da Internet. “There is no other way to extend it to the level of individual citizens,” Laaksonen notes. “não há outra maneira de estendê-lo ao nível dos cidadãos individuais”, observa Laaksonen, ou seja, são semi automáticos porque preveem a interação humana na categorização.

O artigo completo pode ser lido no site da Aalto University de Helsinque.

O caçador de Androides é replicante

O replicante significa uma máquina com feições humanoides e em poucas coisas além da feição se aproxima do humano, no caso dos androides de Blade Runner 2049, o olho ou melhor o fundo da íris que tem um tom alaranjado é o grande diferencial, porém sendo máquina possui características que são super-humanas, por exemplo, a força, a velocidade e muitas outras características poderão ser humanas, mas robôs teriam alma ?

além da feição se aproxima do humano, no caso dos androides de Blade Runner 2049, o olho ou melhor o fundo da íris que tem um tom alaranjado é o grande diferencial, porém sendo máquina possui características que são super-humanas, por exemplo, a força, a velocidade e muitas outras características poderão ser humanas, mas robôs teriam alma ?

Ou fazer a pergunta mais comum na mídia, robôs dormem contando carneirinhos que são máquinas, entretanto a pergunta mais forte desde o início da primeira versão do filme de 1982, é se Rick Deckard (Harrison Ford), o caçador de androides é um também androide, e lógica diz isto porque caçar “máquinas” só mesmo para máquinas.

Uma pergunta que o diretor já respondeu afirmativamente, mas há uma dica no filme quando ele conta que sonhou com um unicórnio (a referência já é pela nossa classificação um replicante, pois tem coisas supra-humanas como um chifre), e alguém já sabia do seu sonho, isto é, os replicantes tem até mesmo seus sonhos projetados, mas porque o “criador” o preservou, uma pergunta que ele próprio se faz.

Ou outro diálogo de Rick Deckard esclarece: “Replicantes são como qualquer outra máquina – eles são um benefício ou um perigo. Se eles são um benefício, não é meu problema”, ou seja, interessa construir uma máquina que ela cuide do perigo que oferecem as outras.

Mas isto é esclarecedor em outro ponto também, há humanos preocupados com as máquinas e isto significa que sem saber que existem perigos, no diálogo Deckard diz como qualquer outra não deveria ser um empecilho para sua existência, o empecilho no fundo é o medo, por isso ao meu ver existe sempre este tom meio sombrio na primeira e segunda versão, chamado pelo refinamento cult de “noir”.

As máquinas e os avanços sempre trazem problemas, desalojam as coisas do lugar de conforto, mas não há como fazer omelete sem quebrar os ovos, é preciso ver os que estão podres, os computadores “sombrios” da Odisséia 2001 já passaram, os androides passarão, o futuro nos pertence, o homem é protagonista de seu futuro, ou ao menos deve desejar sê-lo.