Arquivo para a ‘Computação – Hardware’ Categoria

A sociedade em redes e o ser

Diversos são os autores, a partir de Husserl e Heidegger  que reivindicam um retorno ao ser, a essência do homem e também sua relação com tudo o que está a sua volta, de certa forma também a natureza, embora esta ainda seja negligenciada.

que reivindicam um retorno ao ser, a essência do homem e também sua relação com tudo o que está a sua volta, de certa forma também a natureza, embora esta ainda seja negligenciada.

Pode-se aprofundar este tema remetendo a Levinas e Ricouer, estes mais atuais, e também de certa forma a Habermas e Morin, mas queremos focar apenas nas “redes”.

Castells é um dos principais autores a descobrir este tema, principalmente se pensamos que ele escreveu em 1996, quando as “redes sociais” eram apenas esboços e não populares.

Num dos tópicos dos seus três volumes escreveu que a sociedade estaria cada ver mais estruturada numa bipolaridade entre a rede e o ser.

É surpreendente e sem dúvida uma profunda revisão antropológica e ontológica do ser, onde o ser humano deve vencer as resistências e obstáculos a uma sociedade emergente que seria a “sociedade em rede”.

Castells(*) capta algo essencial que é esta revisão ou mudança histórico do ser (e no ser que lhe escapa) que permitiria emergir uma nova sociedade, onde a sensação de isolamento e de falta de identidade, onde há uma falta de princípios e valores coerentes que possam orientar tanto o processo comportamental como definir diretrizes para uma nova vida de cada ser.

O autor parece colocar diante da sociedade o horizonte de uma humanidade verdadeira, e, assim, que mesmo assim não deixar desaparecer a tensão entre o ideal (que não é o virtual, porque não tem potencial de existência) e o real, que constitui a vida do homem como ser histórico.

O autor não orienta de modo ontológico para uma sociedade coletiva, onde os modelos, os atores e os locais da revolução tecnológica parecem equilibrar mecanicamente as consciências de modo a dar consistência e objetividade às raízes sociais da “revolução”.

Retomando os princípios iniciais, com toda a tecnologia, é na sociedade e no homem (por isto de modo ontológico) que toda a mudança e estrutura da sociedade deve emergir.

*Castells escreveu: A sociedade em Rede, ed. Paz e Terra.

Samsung mini S4 chegam no Brasil

O aparelho S4 chegou no Brasil, rodando a versão mais recente do Android (Jelly Bean), dual chip, nas cores preta e branca,  com a tela super Amoled de 4.3 polegadas, processador dual-core de 1.7 GHz, 3G e 4G, com o preço de R$ 1.399.

com a tela super Amoled de 4.3 polegadas, processador dual-core de 1.7 GHz, 3G e 4G, com o preço de R$ 1.399.

Ele tem pesa 107 gramas, tem 8.9 de espessura e vem com as ferramentas S Translator e Story Album,

A Samsung está preparando uma versão própria do relógio com comunicação gadgets e em junho, apresentou no Escritório de Marcas e Patentes dos EUA a marca “Samsung Gear”, descrito como “relógios que se comunicam com smartphones, tablets, PDA e computadores pessoais pela internet ou outras redes de comunicação eletrônica” (TrustedReview)

O aparelho será para concorrer com o já patenteado iWatch da Apple que deve sair ainda este ano, enquanto a Sony já apresentou a segunda versão, o SmartWatch 2 nesta terça-feira (9/7) na Mobile Asia Expo de Xangai.

As versões Sony do SmartWatch também rodam Android.

As disputas dos Androids com o mercado privativo da Apple promete, a Samsung tem vencido algumas batalhas segundo a StatCounter o número de dispositivos móveis no mundo da sul-coreana é de 25,47% enquanto da Apple 25,09%.

The Androids of disputes with the private market promises Apple, Samsung has won some battles according to StatCounter (no The Telegraph) number of mobiles in the world of South Korean Samsung is 25.47% while 25.09% of Apple.

Como tornar as nuvens seguras

Este foi o problema tratado pela equipe de pesquisa do MIT, dirigida pelo professor Srini Devadas, os estudantes da graduação Ling Ren, Xiangyao Yu e Christopher Fletcher, assim como o pesquisador Marten van Dijk, trabalharam numa tipo de memória não coo um arranjo como é conhecido, mas em uma estrutura de dados conhecida como “árvore”, noticiado pelo MIT.

Este foi o problema tratado pela equipe de pesquisa do MIT, dirigida pelo professor Srini Devadas, os estudantes da graduação Ling Ren, Xiangyao Yu e Christopher Fletcher, assim como o pesquisador Marten van Dijk, trabalharam numa tipo de memória não coo um arranjo como é conhecido, mas em uma estrutura de dados conhecida como “árvore”, noticiado pelo MIT.

Cloud computing significa a terceirização de tarefas computacionais através da Internet, que por um lado possa dar aos usuários de computadores domésticos um poder de processamento sem precedentes e que as pequenas empresas possam usar de serviços de Web mais sofisticados, sem a construção de enormes bancos de dados em servidores.

Mas justamente esta terceirização pode levar a enormes problemas de segurança, como a nuvem é tratada como um condomínio, pode acontecer como citam no artigo de MIT apresentado num Simpósio Internacional de Arquitetura de Computadores, supondo um conjunto de servidores em nuvem para ter a execução de 1.000 aplicativos para clientes simultâneos, sem o conhecimento do exato serviço de hospedagem que é prestado, um desses aplicativos pode ter outra finalidade, a de espionar os outros 999.

No Simpósio Internacional de Arquitetura de Computadores recém acontecido junho, os pesquisadores do MIT descreveram um novo tipo de componente de hardware seguro, chamado Ascend, que misturam os padrões de memória de acesso a um servidor, o que torna impossível no caso de um atacante inferir nos dados que estão armazenados.

Mas talvez só as empresas poderosas e governos consigam usar isto, o que se discutem é quem pode controlar e não se o controle da informal é legal, vejam como todos os estados tratam Snowden, que fez a denuncia inicial de dados: algum país vai recebê-lo ?

Mas a solução no Brasil será o lançamento de um satélite brasileiro, dois cabos submarinos e a instalação de um Ponto de Troca de Tráfego (PTT) internacional, gostamos de coisas caras.

Como foi o 4G na Copa

Conforme previsto houve muitas falhas nas comunicações 4G e o volume de dados foi final, os dados da final da Copa no jogo Brasil x Espanha foram de 1,7 milhão de ligações de telefonia celular e mais de 4,6 milhões de comunicações de dados, incluindo envio de e-mails, fotos e mensagens multimídia, com tamanho médio de 0,5 MB.

Do total de comunicações de dados, cerca de 4 milhões foram na tecnologia 3G e 650 mil pelas redes de 4G, o que resulta algo em torno de 18%.

o que resulta algo em torno de 18%.

Cesar Alvarez, tinha ido ao Rio de Janeiro participar de um encontro da Fifa sobre as telecomunicações e mesmo com o Maracanã vazio, não conseguiu fazer uma ligação de dentro do estádio, e disse que teria naquele mesmo dia uma reunião com a empresa para saber o que havia acontecido, nos momentos de concentração de pessoas também foram observadas muitas falhas.

Assim admitiu que não está funcionando como deveria, mas considerando apenas o entorno dos estádios onde as empresas procuram “caprichar”, imagina o que acontece com o resto do país.

A proposta do leilão de LTE na frequência de 2,5 GHZ previa que 50% das áreas urbanas das seis cidades sede da Copa das Confederações estariam cobertas a partir de 1º de junho, mas não aconteceu.

Rede barata via satélite

Foi lançado ontem a borda de uma espaçonave Soyuz,  na Guiana Francesa, quatro satélites que vão operar a rede O3b (Other 3 billion), que oferecerá uma conexão de internet de alta velocidade por baixo preço preço para 3 bilhões de pessoas, para 180 países.

na Guiana Francesa, quatro satélites que vão operar a rede O3b (Other 3 billion), que oferecerá uma conexão de internet de alta velocidade por baixo preço preço para 3 bilhões de pessoas, para 180 países.

A ideia surgiu em 2007 da mente do americano Greg Wyler, pioneiro da telefonia 3G e fundador da O3b Networks, quado viajava por Ruanda.

Os satélites cobrirão uma faixa de 45 graus em torno da linha do Equador, cobrindo assim regiões carentes da África, da América Latina, o sudeste asiático, a Austrália e a Oceania.

A rede, a internet e a Web

Eram anos da guerra fria, a tensão permanente entre o mundo comunista comandado pela União soviética e o mundo capitalista comandado pelos EUA, e a primeira ideia da rede eletrônica era não ter um comando central de modo que pudesse manter as ligações em caso de destruição de alguns pontos por uma guerra entre os dois blocos em tensão.

Assim a rede deveria ser montada sem um comando central, um sistema no qual todos os pontos (os nós da rede) tivessem autonomia e por onde os dados transmitidos em qualquer direção ou ordem, não perdessem os conteúdos, estava delineado o projeto ARPAnet de Paul Baran, idealizado pela Agência de Projetos de Pesquisa Avançada (Advanced Research Projects Agency) do governo dos EUA.

Mas a rede saiu do controle militar e em 1970 interligava quatro universidades norte-americanas, mas nos 4 anos seguintes o número cresceu para 40. A troca de mensagens e de arquivos torna-se possível, e as universidades lançam diversos projetos, entre eles, o Projeto Gutenberg de Michael Hart com a divulgação de livros, na universidade de Illinois, em 1971.

Naquele mesmo ano, é criada a primeira rede comercial nos EUA, a Telenet, como um serviço de acesso.

O nome Internet foi usado apenas em 1982. Em 1983, Vinton Cerf e Khan criam o protocolo de comunicação da rede, o TCP/IP (Transmission Control Protocol/Internet Protocol), a base comum de instruções e códigos usados por todos os computadores conectados à rede até hoje.

Mas a Web, como um protocolo de aplicação só chegou em 1991, com o sistema de hipertexto, profetizado por Ted Nelson anos antes, e agora implementado por Tim-Berners-Lee, chegava o www, a World Wide Web.

Assim a metáfora da rede se torna anos depois um meio eletrônico de comunicação a internet, e na década de 90 um modo de comunicação entre bilhões de pessoa que é a Web.

As redes sociais só foram possíveis dentro deste universo do hipertexto tendo como meio a Internet.

Lei de Moore tem obstáculos

A lei de Moore foi estabelecida pela primeira vez em 1965 por Gordon Moore, co-fundador da Intel em 1968 e, que em 1975 tornou-se um executivo da empresa.

A lei de Moore foi estabelecida pela primeira vez em 1965 por Gordon Moore, co-fundador da Intel em 1968 e, que em 1975 tornou-se um executivo da empresa.

O artigo original sobre a lei, publicado na revista eletrônica em 1965, tinha como foco aspectos econômicos relacionado ao custo por transistor, tecnologia anterior e a escala da nova tecnologia que era a Escala do Circuito impresso (SI), que crescia da pequena escala de integração (SSI) para a média escala (MSI), depois na década de 70 veio a larga escala (LSI).

Mas agora fabricar chips cada vez menores, mantendo o ritmo com a Lei de Moore talvez seja mais difícil hoje do que era no ano passado, disse William Holt, vice-presidente executivo e gerente geral do Grupo de Tecnologia de Manufatura da Intel, num discurso na Conferência Jeffries Global Technology, Media e Telecom da segunda semana de maio, e noticiada no PC World.

“Estamos mais perto de um fim do que éramos há cinco anos atrás? Claro. Mas somos nós para o ponto onde podemos realmente prever o efeito, nós não pensamos assim. Estamos confiantes de que vamos continuar a fornecer o blocos de construção básicos que permitem melhorias em dispositivos eletrônicos “, disse Holt.

Intel ainda tem a tecnologia de fabricação mais avançada da indústria de chips de hoje, mas foi preciso construir muitas novas fábricas para novos processos de chips, usando materiais novos como tungstênio e Germanio (Ge) para atingir a escala dos 90 e 65 nanômetros, e mais recentemente os gates high-k metal, de 45 nm e 32 nm.

As tecnologias abaixo de 22 nm (chamada Silvermont) já trabalham com estruturas 3D mas o futuro deve ser dos grafenos e chips quânticos, para andar na velocidade que andava a lei de Moore.

Amazon começa vender Kindle HD

A Amazon começou a vender nesta quinta-feira o tablet Kindle Fire HD, em duas versões de 8,9 polegadas e de 7 polegadas, entreos 170 países incluídos, segundo o site Mashable, estão os EUA,  Reino Unido, Alemanha, França, Espanha, Itália e Japão, mas o Brasil fica de fora.

Reino Unido, Alemanha, França, Espanha, Itália e Japão, mas o Brasil fica de fora.

Mas o dispositivo só será entregue a partir de 13 de junho, segundo o site o dispositivo de 7 polegadas custa US$ 214, sem frete, já o de 8,9 polegadas sai por US$ 284.

Amazon.com teve uma alta de 22% na sua receita no primeiro trimestre, saltando para US$ 16,07 bilhões, devido principal a alta nas vendas de conteúdo digital, nos serviços de computação em nuvem e ganhos em seu principal negócio de varejo: os livros.

Por aqui, as opções seguem sendo o Kindle tradicional e o Kindle Paperwhite que custa o R$ 479, sendo o modelo de e-reader mais avançado no país.

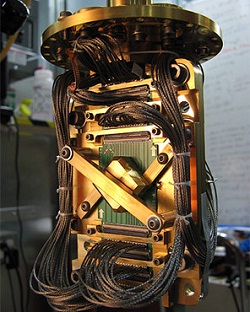

NASA e Google se unem para computador quântico

O computadores quânticos aqueles que usam os princípios da física quântica para modificar  o processamento binário dos computadores atuais, e dos bits binários 0 e 1 usarão qubits, que teriam muitos mais valores podendo, por exemplo, associados a fotônica usarem 7 qbits para o espectro da luz, com as cores do arco-íris.

o processamento binário dos computadores atuais, e dos bits binários 0 e 1 usarão qubits, que teriam muitos mais valores podendo, por exemplo, associados a fotônica usarem 7 qbits para o espectro da luz, com as cores do arco-íris.

Segundo o diretor de Engenharia do Google, Hartmut Neven, no post que anunciou a criação de um laboratório em conjunto com a Nasa: “Acreditamos que a computação quântica pode ajudar a resolver alguns dos mais desafiadores problemas da ciência da computação, especialmente em termos de aprendizado”, falando sobre a Inteligência Artificial, isto porque “Aprendizado de máquinas é basicamente construir modelos melhores do mundo para fazer previsões mais precisas.”

Mas o problema não é só a construção do computador, cada vez mais próximo da realidade, há ainda o problema de criar algoritmos capazes de usar estas propriedades únicas que o qubits oferecem, como informação básica que não seja apenas 0 e 1.

O Google afirma estar progredindo nesse aspecto, Neven disse: “Já criamos alguns algoritmos de aprendizado de máquinas quânticas. Um produz reconhecedores muito compactos e eficientes – muito úteis quando você tem pouca energia elétrica disponível, como em um dispositivo móvel”, que seria um uso imediato para os qubits.

O laboratório está construindo o D-Wave, mas que é construído numa concepção um pouco diferenciada da computação quântica, com o modelo adiabático, que é muito diferente dos modelos de “portas” (gates) que toda a comunidade que pesquisa no tema usa.

Isto leva muitos críticos a um ceticismo de alguns críticos, mas testes desta semana da faculdade feitos na universidade de Amherst mostra que com certas tarefas, o computador quântico do laboratório funcionou muito bem.

Projeto aberto de Data Center

Um projeto intitulado OCP (Open Compute Project ) foi iniciado ontem num esforço de construir um centro de dados abertos para a rede, com um modelo flexível e eficiente, que evite desperdício de componentes desnecessários, com um sistema totalmente aberto a todos prestadores de serviços e desenvolvedores de hardware para DataCenters.

Um projeto intitulado OCP (Open Compute Project ) foi iniciado ontem num esforço de construir um centro de dados abertos para a rede, com um modelo flexível e eficiente, que evite desperdício de componentes desnecessários, com um sistema totalmente aberto a todos prestadores de serviços e desenvolvedores de hardware para DataCenters.

Entre os apoiadores iniciais do projeto já estão o Facebook, Intel e VMware, além de potências tradicionais em redes como a Netronome e Broadcom.

Em entrevista ao site v3, o presidente da OCP Frank Franovsk afirmou: “É nossa esperança que um sistema alternativo aberto permita um ritmo de inovação e desenvolvimento de hardware de rede, que ajude as definições de software continuarem evoluindo e prosperarem e, por fim, proporcionar aos consumidores destas tecnologias mais liberdades para construir estas infraestruturas mais flexíveis, escaláveis e eficientes a disposição”, conforme o site v3.co.uk .

Confirmando que é um novo tipo de empresa, aberto e colocada numa folha em branco, conformo afirma o presidente, onde esta empresa: “Este é um novo tipo … começando um projeto com apenas uma ideia e uma folha de papel, em vez de construir em um projeto existente que seria concebido para a fundação , e estamos animados para ver como o grupo de projeto proporciona em nossa visão coletiva “.

A ideia de projetos assim, num modelo misto com uso do crowdsourcing, está evoluindo, como prova o projeto Ouia (veja nosso post).