Arquivo para a ‘Circuitos’ Categoria

Presente de Natal

Em dezembro de 1947, bem próximo do Natal, três engenheiros da Bell Telephone (William Shockley, John Bardeen e Walter Brattain) inventaram o transistor (TRANsfer reSISTOR) que revolucionária a comunicação e mais tarde a computação, também os CIs (Circuitos Integrados) tem como base o transistor.

Bell Telephone (William Shockley, John Bardeen e Walter Brattain) inventaram o transistor (TRANsfer reSISTOR) que revolucionária a comunicação e mais tarde a computação, também os CIs (Circuitos Integrados) tem como base o transistor.

O grande evento deste Natal será o lançamento do observatório espacial James Webb (jwst, James Webb Space Telescope) da base espacial de Kourou, na Guiana Francesa, no horário das 9h20 (horário de Brasília) que vai ser levado para nave especial Ariane 5, feito com o custo de U$ 10 bi, o mais caro projeto espacial da história.

O que vamos procurar no espaço, além de outros enigmas, a origem do universo em seu estágio inicial, e é curioso que isto acontece neste Natal, e porque ele é tão especial.

Luzes enfeitam cidades mesmo em atenção com uma possível nova onda da pandemia e também uma nova gripe, acendem esperanças e nos fazem olhar para o futuro e para o início de nossas vidas, do nosso planeta e da humanidade.

Não há como fugir de utópicas, cosmogonias e escatologias religiosas, mesmo que possamos resolver muitos enigmas fica a pergunta filosófica: porque existe tudo e não o nada.

A resposta só pode ser ontológica, há uma razão para ser e há um futuro promissor, onde haja esperança se retornamos a lógica do Ser, do diálogo e do encontro com o Outro.

A mensagem não pode ser outro senão aquela que fala de fraternidade e de paz, ambos ainda não totalmente alcançados pela humanidade, o Natal reabre esta esperança.

É esta a profecia que anuncia Isaías (Is 52,7 quando que haverá uma paz verdadeira: “como são belos, andando sobre os montes, os pés de quem anuncia e prega a paz, de quem anuncia o bem e prega a salvação, e diz a Sião: ‘Reina teu Deus’”, a mensagem que acreditava na vinda do Salvador, o nascimento entre os homens do Messias.

As luzes na cidade não anunciam apenas esta luz visível aos olhos, mas aquelas que abrem o coração para a amizade e a paz (Jo 1,4-5): “nela estava a vida, e a vida era a luz dos homens. E a luz brilha nas trevas, e as trevas não conseguiram dominá-la”, porque um ponto mínimo de luz já dissipa a escuridão, e esta é a nossa esperança.

Que o Natal renove as esperanças, num futuro possível e sustentável para a humanidade, e que a justiça e paz reinem num novo mundo.

Projeto avançado Deep Mind

Projetos que tentavam simular sinapses cerebrais, a comunicação entre neurónios, foram anteriormente chamados de redes neurais ou neuronais, e tiveram um grande desenvolvimento e aplicações.

chamados de redes neurais ou neuronais, e tiveram um grande desenvolvimento e aplicações.

Aos poucos estes projetos foram se deslocando para estudos da mente e o código foi sendo dirigido para Machine Learning (Aprendizado por máquina) que agora usando redes neurais passou a ser chamado deep learning, um projeto avançado é o Google Brain.

Basicamente é um sistema para a criação e treinamento de redes neurais que detectam e decifram padrões e correlações em sistemas aplicados, embora análogo, apenas imitam a forma coo os humanos aprendem e raciocinam sobre determinados padrões.

O Deep Learning é um ramo da Machine Learning que opera um conjunto de algoritmos usado para modelar dados em um grafo profundo (redes complexas) com várias camadas de processamento, e que diferente do treinamento de redes neurais, operam com padrões tanto lineares como não lineares.

Uma plataforma que trabalha com este conceito é a Tensor Flow, originada de um projeto anterior chamado DistBelief, agora é um sistema de código aberto, lançado pela equipe da Apache 2.0, em novembro de 2015, o Google Brain usa esta plataforma.

Em maio de 2016, a Google anunciava para este sistema a TPU (Tensor Processing Unit), um acelerador de programas de inteligência artificial programável com habilidade de alta taxa de transferência para a aritmética de baixa precisão (8 bts), que executa modelos e não mais treina como faziam as redes neurais, inicia-se uma etapa da Deep Compute Engine.

O segundo passo deste processo no Google Compute Engine, a segunda geração de TPUs alcança até 180 teraflops (10^12 números reais) de desempenho, e montados em clusters de 64 TPUs, chegam a trabalhar até 11.5 petaflops.

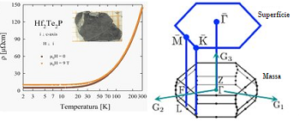

Material pode ajudar criação de chips quânticos

Pesquisadores da Universidade Central da Flórida (UCF) descobriram um tipo de material que poderia ser usado como um “bloco de construção” de chips quânticos, sendo composto de háfnio, telúrio e fósforo, Hf2Te2P.

ser usado como um “bloco de construção” de chips quânticos, sendo composto de háfnio, telúrio e fósforo, Hf2Te2P.

Segundo o pesquisador Madabe Neupane, da UFC: “Nossa descoberta nos leva um passo mais perto da aplicação de materiais quânticos e nos ajuda a obter uma compreensão mais profunda das interações entre várias fases quânticas”.

O material tem mais de um padrão de elétrons que se desenvolve dentro de sua estrutura eletrônica, dando-lhe uma gama de propriedades quânticas. Neupane diz que este material aumentará o poder de computação para grandes volumes de dados em novos dispositivos e reduzirá consideravelmente a quantidade de energia necessária para a eletrônica de potência.

A descoberta já atraiu empresas que estão investindo na pesquisa, a Microsoft por exemplo investiu em seu projeto chamado Estação Q, o laboratório que está dedicado ao campo da computação quântica topológica, e a google se associou à NASA num investimento que trabalha com computação quântica e inteligência artificial.

Como os fenômenos quânticos precisam ser melhores compreendidos para que a eletrônica seja totalmente substituída pela fotónica e pela computação quântica, as mudanças de cenário computacional tendem a mudar rápida e continuamente.

A descoberta do laboratório de Neupane está publicada na Nature Communications, e é um grande passo para esta mudança de cenário.

Assistentes pessoais chegam ao consultório

Em alguns consultórios médicos já se utilizam o Google Home, Assistant e Translate, além da  indispensável Agenda, quem a começa a utilizar não a deixa mais, evita conflitos de horários e avisa esquecimentos, mas a ideia agora é integrar estes ambientes no “Medical Digital Assist”, desenvolvido pelo médico Steven Lin da Universidade de Stanford feito junto ao CNBC.

indispensável Agenda, quem a começa a utilizar não a deixa mais, evita conflitos de horários e avisa esquecimentos, mas a ideia agora é integrar estes ambientes no “Medical Digital Assist”, desenvolvido pelo médico Steven Lin da Universidade de Stanford feito junto ao CNBC.

Segundo o site da CNBC, o projeto esta no grupo de saúde do audacioso projeto Google Brain, parte da divisão da Google em inteligência artificial, tendo como seu “objetivo ambicioso” de implantar testes com pacientes de saúde externos antes do final de 2018.

O objetivo principal, entretanto, é auxiliar os médicos em seus relatórios e prontuários médicos, antes de iniciar os estudos a Escola de Medicina de Stanford fez um levantamento onde verificou que os médicos perdem de 6 a 11 horas de seus trabalhos diários para documentar os históricos clínicos dos pacientes, por isto muitas vezes é mais fácil perguntas, mas as respostas dos pacientes podem ser imprecisas ou ignorar dados relevantes.

O problema da precisão é fundamental, o site da CNBC explica a diferença entre uma interpretação e “hipo” ou “híper” pode ser fatal, hipoglicemia é exatamente o oposto de hipoglicemia, se o médico não verificar isto cuidadosamente, inclusive na interpretação em IA.

A primeira fase deste estudo está prevista como conclusão em agosto, Lin disse que ambas as partes planejam renovar a colaboração para a segunda fase por ao menos por um ano.

Consta-se que a Microsoft e a Amazon também estão desenvolvendo sistemas semelhantes me inteligência artificial, e o foco principal permanece em elaborar os relatórios clínicos.

Insegurança do hardware da Intel

O armazenamento de dados tinha 3 níveis: a memória externa (HDs), a  memória do computador (as memórias RAMs) e as bem internas antes chamadas Register (ficam no chip) e hoje de memória de núcleo, ficam no núcleo do computador e são as mais rápidas, mas também podem ser janelas para roubo de dados, hoje há um quarto nível que é a externa armazena em nuvens, centro de computação espalhados pelo mundo que vendem estes armazenamentos.

memória do computador (as memórias RAMs) e as bem internas antes chamadas Register (ficam no chip) e hoje de memória de núcleo, ficam no núcleo do computador e são as mais rápidas, mas também podem ser janelas para roubo de dados, hoje há um quarto nível que é a externa armazena em nuvens, centro de computação espalhados pelo mundo que vendem estes armazenamentos.

Um erro de produção dos chips da Intel, que chegam a quase 90% dos chips de computadores pelo mundo (o dos smartphones são muito diferentes), acaba de ser pega numa falha de projeto que dá vulnerabilidade para os dados.

A AMD, concorrente da Intel, aproveitou para manifestar que sua memória de Kernel (as memórias do núcleo do computador) não são afetadas por ataques de hackers, e não permite acesso a senhas e outros dados sigilosos da máquina, através dos quais os dados de um computador podem ser roubados.

Segundo afirmou Paul Kocher, presidente da empresa de segurança Rambus, para o New York Times, o problema pode ser maior se o acesso foi em nuvens, onde grande partes dos dados hoje já estão sendo armazenados, isto porque o compartilhamento de máquinas (e com isto compartilhamento das memórias de núcleo) podem ser feitos, mesmo se considerando o protocolo de segurança que evita acesso aos outros níveis de memória.

Problemas de segurança com as gigantes Amazon, Microsoft e Google, além da fabricante de chips Intel poderão sacudir o mercado, além da AMD outras concorrentes orientais devem estar de olho, de nossa parte alertamos para o chave problema.

Robôs autônomos ?

Robôs autônomos é a denominação para aqueles que dentro de limites ambientais, podem realizar os objetivos desejados (por humanos ou por tarefas organizadas em um algoritmo) nestes ambientes desestruturados sem a ajuda humana, por isto o são em certos níveis.

podem realizar os objetivos desejados (por humanos ou por tarefas organizadas em um algoritmo) nestes ambientes desestruturados sem a ajuda humana, por isto o são em certos níveis.

Por exemplo, dentro de uma fábrica onde tarefas mecânicas são realizadas, para evitar acidentes o seu espaço geográfico é limitado e deve detectar algum defeito que possa cumprir determinada tarefa fora do previsto, já um robô espacial deve ter menos limites e ser o mais autonomo possível, por estar sem a possibilidade de uma ação humana direta e ter dificiuldades de comunicação devido a distância.

O projeto chamado SWARM, financiado pela União Européia e que já fizemos um post, agora tem o primeiro sistema multi-robôs de autono montagem que tem coordenação sensório-motor observando robôs parecidos ao seu redor, eles vão variar de forma e tamanho conforme sua tarefa e/ou ambiente de trabalho.

Um ssitema “cerebral” central coordena todos eles, através de um sistema chamado MNS (Sistema Nervoso Combinal, em português), e assim são reconfigurados absorvendo diferentes capacidades mas combinadas por um único controlador central.

Eles também podem se dividir e realizar tarefas de auto reparo, eliminando partes do corpo com defeito, incluindo uma unidade cerebral com algum defeito, claro que pode-se definir que estes defeitos e auto reparos possuem limitações conforme a complexidade.

Em robos autônomos, o aprendizado refere-se a aprender e ganhar novas capacidades sem assistência externa e ajustar estratégias de acordo com o ambiente, o que pode fazer com que sua autonomia aumente, mas pelo que se pode ler do artigo ainda não é o caso.

O modelo atual tem 10 unidades, e os autores apontam no paper publicado na Nature Communications, afirmam que o projeto é escalável, tanto em termos de recursos computacionais para controle robótico quanto tempo de reação para estímulo, dentro do sistema.

Olhando para o futuro, a equipe sugere que os robôs provavelmente serão projetados para adaptação aos requisitos de tarefa em mudança e não mais somente para tarefas específicas.

Como andam as pesquisas sobre cyber-cérebros ?

Há muita pesquisa mapeando os cérebros, e investigando aspectos de como funcionam determinadas funções tais como: a função motora, a visão, e de modo muito especial o da Neurociência Cognitiva estuda a capacidade cognitiva (conhecimento) de uma pessoa, como o raciocínio, a memória e o aprendizado.

como funcionam determinadas funções tais como: a função motora, a visão, e de modo muito especial o da Neurociência Cognitiva estuda a capacidade cognitiva (conhecimento) de uma pessoa, como o raciocínio, a memória e o aprendizado.

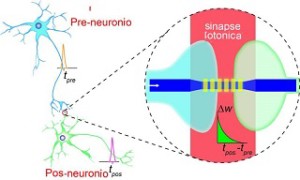

Um estudo recente feito pelas universidades de Exeter e Oxford do Reino Unido, em conjunto com a Universidade de Münster na Alemanha, desenvolveu microchips fotônicos que imitiram as sinapses do cérebro humano usando a luz e não mais a eletricidade, como em outros chips.

Os chips são fabricados usando o fenômeno de frequência, mas a partir da mudança de fase combinando nos circuitos fotônicos integrados, projetados para isto, com sinapses podem operar em 1.000 vezes a velocidade das humanas, o que não quer dizer que façam o mesmo.

Os pesquisadores afirmam que é um passo fundamental em máquinas capazes de funcionar e na forma de pensar de forma semelhante ao cérebro uma vez que a fotônica é rápida e de baixo consumo de energia.

David Wright, afirmou para o site da Universidade de Exeter, que o projeto aborda duas questões importantes na computação eletrônisca, tanto a rapidez como a eficiência e os problemas da capacidade nos processamentos paralelos, os mais rápidos de agora: “não só pelo desenvolvimento … novas arquiteturas de computadores tipo cérebro, mas também trabalhando no domínio óptico para aproveitar as enormes vantagens de velocidade e potência da próxima revolução fotônica de silício “.

O trabalho On-chip photonic synapse foi publicado no final de setembro, foi publicado pela revista Science Advances, tendo como autores: Zengguang Cheng, Carlos Rios, Wolfram Pernice, C. David Wright and Harish Bhaskaran.

O que dizem do iPhone 8 e plus

Não sei se já disseram alguma coisa antes, mas pude ler os primeiros  comentários ontem do Hi Phone 8 e o modelo plus, Mathew Panzarino do TechCrunch destaca a câmera “com a realidade aumentada e visão computacional emergindo como concorrentes na próxima grande onda de desenvolvimento de plataformas, o sistema de câmera será um [importante] mecanismo de entrada, um sistema de comunicação e uma declaração de intenção”.

comentários ontem do Hi Phone 8 e o modelo plus, Mathew Panzarino do TechCrunch destaca a câmera “com a realidade aumentada e visão computacional emergindo como concorrentes na próxima grande onda de desenvolvimento de plataformas, o sistema de câmera será um [importante] mecanismo de entrada, um sistema de comunicação e uma declaração de intenção”.

Outro site importante de tecnologias é o Engadget, Chris Velazco se viu curioso com os apps tipo ARKit funcionariam e gostou da experiência de realidade aumentada e afirmou que o preenchimento (renderização) de objetos virtuais em planos físicos os fazem “grudar nas superfícies melhor que os similares apps Tango”.

Outro site forte na área é The Verge, o comentário de Nilay Patel foi: “assim como na Samsung, as imagens do iPhone agora são mais saturadas por padrão, embora a Apple diga que ainda está visando realismo em vez das cores saturadas e as suavizações do S8” e afirmou mais a frente que tirando fotos com um iPhone 8, um Pixel XL, um S8 e um iPhone 7 “no automático, e o iPhone 8 produziu as imagens mais consiste e ricas do grupo”.

A novidade no software ficou por conta do recurso Iluminação de Retrato, que permite efeitos de luz com a câmera frontal, a bateria dura cerca de 11 horas avisa outro review,

Por fim o último, mas o mais importante site de tecnologia David Pierce da Wired, afirmou que “os celulares são muito bons e impressionantes, e ainda assim não são os melhores aparelhos da Apple. O iPhone X representa a visão do futuro da Apple, e também da Samsung, da Essential, da Huawei e muitos outros.”

Espera-se muito cada vez mais de câmeras e Apps de tratamento gráfico, o desempenho e a memória parecem são importantes, mas estão ficando em segundo plano, o site TechCrunch por exemplo nota que “o chip A11 da Apple tem um desempenho que é compatível com o Core i5 do MacBook Pro”.

Com a importância gráfica e tratamento de imagens telas OLED de maior definição serão importantes.

Histórias desconhecidas da computação

Charles Babbage construiu duas máquinas chamadas Analytical Engine e Diferential Engine, estas máquinas, suas sistematizações e pensamentos não teriam chegadas até nós não fosse o trabalho paciente de Ada de Lovelace (1815-1852), filha de Lord Byron que compilou e organizou o trabalho deste pioneiro, tornando-o compreensível aos matemáticos da época.

estas máquinas, suas sistematizações e pensamentos não teriam chegadas até nós não fosse o trabalho paciente de Ada de Lovelace (1815-1852), filha de Lord Byron que compilou e organizou o trabalho deste pioneiro, tornando-o compreensível aos matemáticos da época.

Mais tarde David Hilbert (1862-1943) listou 23 problemas matemáticos sem soluções, dos quais um deles era organizar um sistema algébrico de modo a resolver a questão da computabilidade de problemas por algoritmos, Kurt Gödel pensando neste problema cria um paradoxo sobre a completude de sistemas, afirmando que não poderá provar tendo a prova por uma asserção dentro do sistema, então problemas de consistência debilitam tais sistemas.

Assim era necessária que a lógica além de ser construída com boas propriedades: tivesse consistência (ausência de contradições), completude (qualquer proposição seria ou verdade ou falsa de forma exclusiva) e o sistemas fossem decidíveis (existência dum método permitindo estabelecer se uma fórmula qualquer determinasse se a formula era verdadeira ou falsa).

Esta última propriedade foi chamada por Hilbert como o “entcheidungsproblem”, ou problema da “decisão”.

Alan Turing e Claude Shannon trabalhando em maquinas de codificação (para mensagens do governo americano) e decodificação (uma máquina chamada Enigma foi capturado do exercito de Hitler), como ambos os projetos eram secretos, se encontram em refeições e intervalos do trabalho, conforme indica o livro de James Gleick e conversam sobre o problema proposto por Hilbert e não solucionado por Gödel, um documento secreto prova esta passagem de Turing, que era inglês, pela Bell Laboratories, onde trabalhou em decifrar o código da máquina Enigma.

Durante o trabalho de Claude Shannon no laboratório de Vannevar Bush, este sugeriu a ele a Álgebra de Boole.

Shannon neste período trabalhou como monitor no MIT no laboratório de Vannevar Bush, que havia proposto uma máquina “de leitura” chamada de MEMEX (apareceu na revista TIME – foto) não era propriamente um computador, mas uma máquina para cruzar informações de livros (a máquina do seu laboratório era para traçar gráficos estatísticos).

Mais tarde usando o modelo do matemático Alonzo Church que finalizou o projeto de Alain Turing , e a chamada Máquina de Turing é na verdade baseada no modelo de Turing/Church.

O modelo de Norbert Wiener eram máquinas de modelos eletrônicos de feedback, embora seja ele que fundou a Cibernética, a ideia era de criar modelos para movimentos e transformá-los em modelos de solução de problemas, eram contemporâneo de Vannevar Bush do MIT.

Chip revoluciona IoT

Uma empresa quase falida resolve investir no desenvolvimento de um chip para a Internet das Coisas (IoT) não só salva a própria empresa como promete revolucionar o mercado.

das Coisas (IoT) não só salva a própria empresa como promete revolucionar o mercado.

O chip é é o ESP8266, da empresa Espressif, o preço $ 5 (5 colares), menor que uma moeda e integrado em diversas soluções, por exemplo, comunicação com a interface serial da maioria dos modelos de computadores, a chamada UART (Unidade Universal de transmissão assíncrona), isto significa transmissão com qual dispositivos com interface TCP da internet.

Veja algumas de suas características descobertas (em inglês é peneiradas, mas em chinês é escondidas mesmo): É um System-On-Chip com Wi-Fi embutido, Tem conectores GPIO, barramentos I2C, SPI, UART, entrada ADC, saída PWM e sensor interno de temperatura, CPU que opera em 80MHz, com possibilidade de operar em 160MHz, Arquitetura RISC de 32 bits, 32KBytes de RAM para instruções, 96KBytes de RAM para dados, 64KBytes de ROM para boot, memória Flash SP e Winbond W25Q40BVNIG de 512KBytes;

Para programa-los, a empresa possui um repositório no GitHub, onde disponibiliza exemplos de código para firmwares com RTOS e comandos AT, e sua SDK, por exemplo, além disso há um fórum de desenvolvedores do ESP8266, mantido pela Espressif, onde é possível encontrar uma ampla gama de materiais.

Será que teremos novos desenvolvedores de garagens pelo mundo